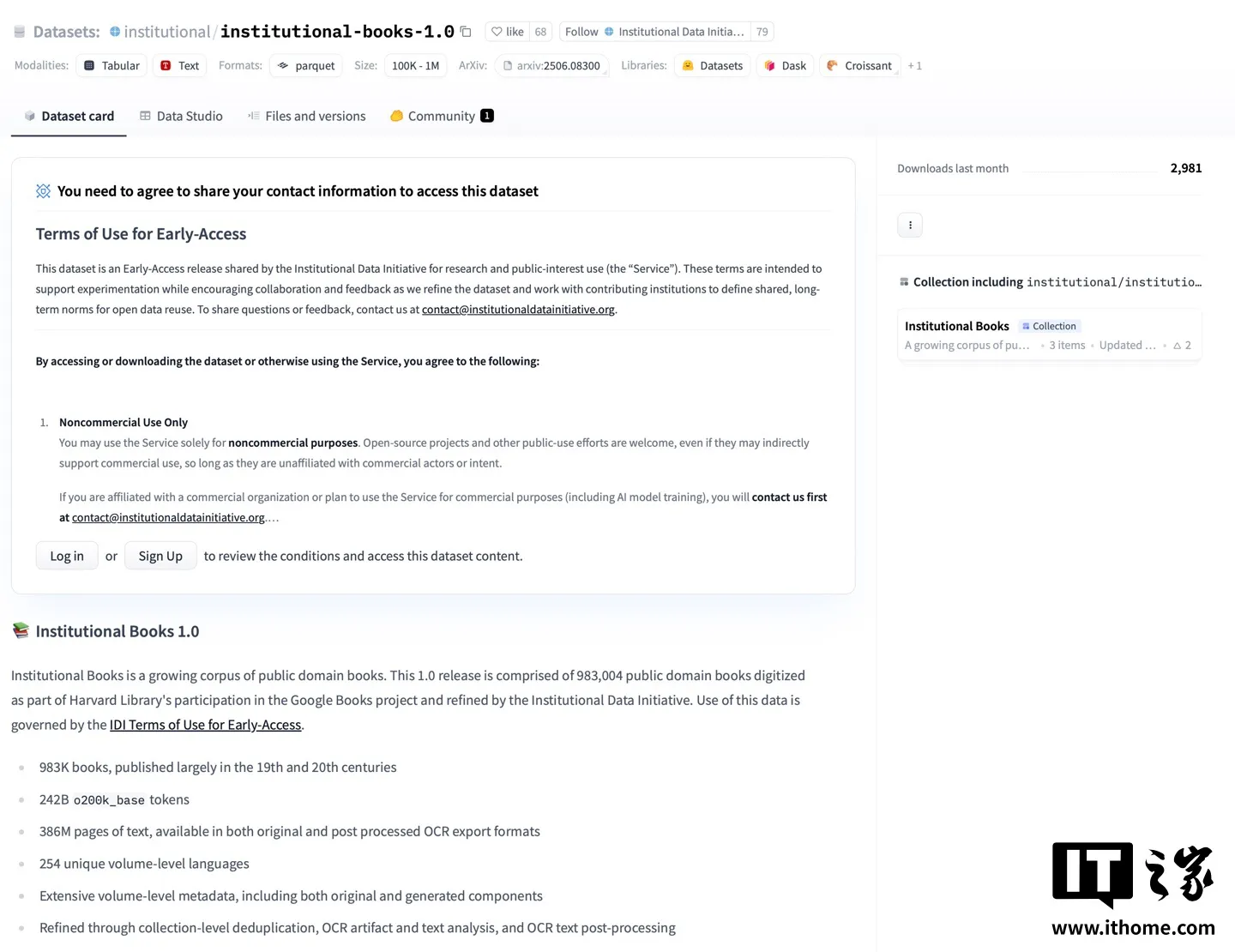

在微软与 OpenAI 的支持下,哈佛大学法学院图书馆于上周正式开源其首个 AI 训练用开放数据集“Institutional Books 1.0”。该数据集据称收录了哈佛大学馆藏中 98.3 万本图书,涵盖 245 种语言,共包含 2420 亿个 Token,AI在线附项目地址(https://huggingface.co/datasets/institutional/institutional-books-1.0)。

据介绍,相应数据集收录的书籍有 40% 为英语,书籍主要出版年代集中于 19 与 20 世纪,共计被划分为 20 项主题,除此之外,相应数据集还提供了每本书的完整元数据,涉及“作者、出版年份、语言、原始来源”等信息。

哈佛大学法学院图书馆表示,未来研究人员还将持续扩充数据内容,目前相应项目组成员已与波士顿公共图书馆展开合作,将把“数百万份”历史报纸以数字化形式添加至上述数据集中。

后续,哈佛大学法学院图书馆还计划开发一系列 AI 工具,以提升馆藏资料整理和开放的效率,推动“负责任的数据使用规范”。