1、模型架构

Qwen3 系列涵盖 6 种密集型模型和 2 种 MoE 模型,参数规模从 0.6 亿到 2350 亿不等,满足不同下游应用需求。旗舰模型 Qwen3-235B-A22B 作为 MoE 模型,总参数量达 2350 亿,每 token 激活参数量为 220 亿,在性能与效率间取得平衡。

密集型模型

Qwen3 的密集型模型架构与 Qwen2.5 类似,采用 Grouped Query Attention(GQA)和 QK-Norm 改进注意力机制,使用 SwiGLU 作为激活函数,搭配 Rotary Positional Embeddings(RoPE)进行位置编码,采用 RMSNorm 并预归一化。此外,Qwen3 移除了 QKV-bias,进一步优化性能。分词器采用基于字节级字节对编码(BBPE)的自有分词器,词汇表大小为 151,669 。

混合专家模型

Qwen3 的 MoE 模型在密集型模型基础上,引入专家分割和负载均衡机制。128 个专家中每个 token 激活 8 个专家,通过全局批量负载均衡损失鼓励专家专门化,且不再使用共享专家,进一步提升模型效率和性能。

2、预训练

预训练任务预训练数据

Qwen3 的预训练数据规模和多样性显著提升,包含 36 万亿个 token,是 Qwen2.5 的两倍,覆盖 119 种语言和方言,是Qwen2.5的四倍。数据来源广泛,具体来说,包括:

- 多语言文本:包括各种领域的高质量内容,如编程、STEM(科学、技术、工程和数学)、推理任务、书籍、多语言文本等。

- 合成数据:利用 Qwen2.5-Math 和 Qwen2.5-Coder 模型生成数学和编程相关的合成数据。

- PDF 文档提取:通过 Qwen2.5-VL 模型从大量 PDF 文档中提取文本,并使用 Qwen2.5 模型进行质量优化。

另外通过多语言数据标注系统进行多维度标注,以便更有效地进行数据过滤和组合,确保数据质量。

预训练阶段

Qwen3 的预训练过程分为三个阶段,每个阶段都有其特定的目标和数据集:

- 通用阶段(S1):在首个预训练阶段,所有 Qwen3 模型均使用 4096 token 的序列长度,在超过 30 万亿 token 上进行训练。在此阶段,模型全面学习语言能力和通用世界知识,训练数据覆盖 119 种语言和方言。

- 推理阶段(S2):为进一步提升推理能力,通过增加 STEM、编码、推理和合成数据的比例优化该阶段的预训练语料库。模型使用 4096 token 的序列长度,在约 5 万亿高质量 token 上继续预训练,并在此阶段加速学习率衰减。

- 长上下文阶段:在最后的预训练阶段,收集高质量长上下文语料库以扩展 Qwen3 模型的上下文长度。所有模型使用 32768 token 的序列长度,在数百亿 token 上进行预训练。长上下文语料库中,75% 的文本长度在 16384 至 32768 token 之间,25% 在 4096 至 16384 token 之间。沿用 Qwen2.5的做法,通过 ABF 技术将 RoPE 的基础频率从 10,000 提升至 1,000,000。同时引入 YARN和双块注意力,以在推理阶段将序列长度处理能力提升四倍。

预训练评估

对 Qwen3 系列的预训练模型进行了全面评估,涵盖了多个任务和领域。评估结果表明:

- 与此前开源的 SOTA 稠密和 MoE 基础模型(如 DeepSeek-V3 Base、Llama-4-Maverick Base、Qwen2.5-72B-Base)相比,Qwen3-235B-A22B-Base 在大多数任务中以显著更少的总参数或激活参数实现了性能超越。

- 对于 Qwen3 MoE 基础模型,实验结果表明:

- 使用相同预训练数据时,Qwen3 MoE 基础模型仅需 1/5 的激活参数即可达到与 Qwen3 稠密基础模型相当的性能。

- 由于 Qwen3 MoE 架构的改进、训练 token 规模的扩大和更先进的训练策略,Qwen3 MoE 基础模型以少于 1/2 的激活参数和总参数超越了 Qwen2.5 MoE 基础模型。

- 仅使用 Qwen2.5 稠密基础模型 1/10 的激活参数,Qwen3 MoE 基础模型仍能实现可比性能,为推理和训练成本带来显著优势。

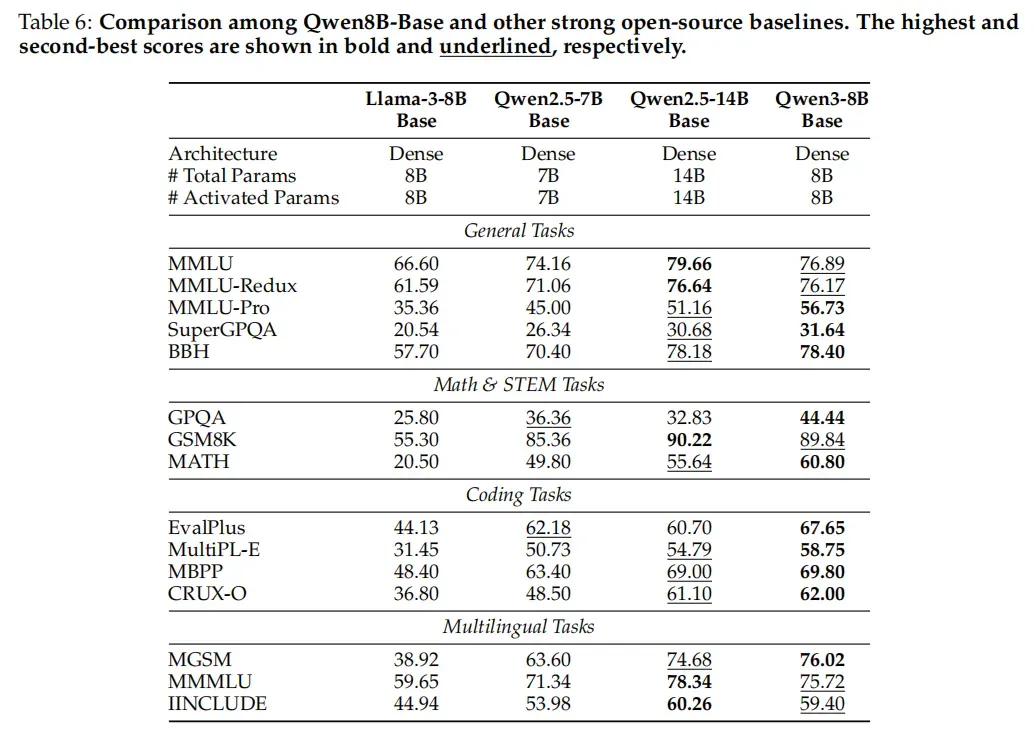

- Qwen3 稠密基础模型的整体性能与更高参数规模的 Qwen2.5 基础模型相当。例如,Qwen3-1.7B/4B/8B/14B/32B-Base 分别与 Qwen2.5-3B/7B/14B/32B/72B-Base 性能相当,尤其在 STEM、编码和推理基准测试中,Qwen3 稠密基础模型甚至超越了更高参数规模的 Qwen2.5 基础模型。

综合来看,Qwen3 的架构设计通过混合专家稀疏激活、长上下文优化和多语言适配,在效率、性能和通用性之间实现了平衡,与相同参数规模的LLM相比,Qwen3以更少的参数实现更优的性能。

3、后训练

Qwen3的后训练流程是Qwen实现思考模式和非思考模式集成的关键,其流程围绕两个核心目标设计,下面来详细介绍下:

- 思维控制:整合 “非思维” 和 “思维” 两种模式,使用户能够灵活选择模型是否进行推理,并通过指定思维过程的 token 预算控制思维深度。

- 强到弱蒸馏:精简轻量级模型的后训练流程,通过利用大规模模型的知识,大幅降低构建小规模模型的计算成本和开发工作量。

Qwen3 系列的旗舰模型采用四阶段训练流程:前两个阶段专注于开发模型的 “思维” 能力,后两个阶段则致力于将强 “非思维” 功能整合到模型中。

初步实验表明,直接将教师模型的输出对数(logits)蒸馏到轻量级学生模型中,可有效提升学生模型的性能,同时保持对推理过程的细粒度控制。这种方法无需为每个小规模模型单独执行完整的四阶段训练流程,不仅通过更高的 Pass@1 分数体现出更好的即时性能,还通过改进的 Pass@64 结果增强了模型的探索能力。此外,与四阶段训练方法相比,该方法仅需 1/10 的 GPU 小时,显著提升了训练效率。

长思维链冷启动

长思维链冷启动(Long-CoT Cold Start)阶段的目标是为模型提供推理能力的基础训练,使其能够处理复杂的多步骤问题。这一阶段的训练旨在:

- 培养基础推理模式:通过处理复杂的多步骤问题,使模型能够逐步构建推理链,为后续的强化学习阶段打下坚实的基础。

- 避免过度依赖浅层猜测:确保模型在解决复杂问题时能够进行深入的思考,而不是依赖于表面的模式匹配或猜测。

为了实现这一目标,构建一个高质量的数据集是这一阶段的关键。数据集需要包含各种类型的复杂问题,以确保模型能够学习到多样化的推理模式。

- 数据来源

- 数学问题:包括复杂的数学题目,如高等数学、线性代数等。

- 编程问题:涉及算法设计、代码生成等任务。

- 逻辑推理问题:如逻辑谜题、推理题等。

- STEM 问题:涵盖科学、技术、工程和数学领域的综合问题。

- 查询过滤为了确保数据集的质量,使用 Qwen2.5-72B-Instruct 模型对查询进行过滤,排除以下类型的查询:

难以验证的查询:例如包含多个子问题或需要一般性文本生成的查询。

不需要推理的查询:Qwen2.5-72B-Instruct 能够正确回答而无需使用推理链(Chain-of-Thought, CoT)的问题。

响应过滤

对于每个剩余的查询,使用 QwQ-32B 模型生成多个候选响应。通过人工标注进一步过滤掉不准确或不符合要求的响应,具体标准包括:(1) 最终答案错误;(2) 内容大量重复;(3) 明显猜测且缺乏充分推理;(4) 思维与总结内容不一致;(5) 不适当的语言混合或风格转变;(6) 疑似与潜在验证集项目过度相似。

冷启动训练:在数据集构建完成后,进行初始的推理模式训练。从经过严格筛选的数据集中选择一部分问题,用于初始的推理模式训练。这一阶段的训练数据量相对较少,以避免模型在早期阶段过度拟合。这一阶段重点是培养模型的基础推理模式,而不是过分强调即时的推理性能。

通过这种方式,模型能够在后续的强化学习阶段中更好地扩展其推理能力。

推理强化学习

这一阶段的目标是通过强化学习进一步提升模型的推理能力,特别是在数学和编程任务中。这一阶段的训练旨在:

- 提升推理能力:通过强化学习,进一步提升模型在复杂推理任务中的表现。

- 优化模型性能:通过优化模型的参数,提高其在推理任务中的准确性和效率。

- 平衡探索和利用:在强化学习过程中,平衡模型的探索(exploration)和利用(exploitation),确保模型能够有效地学习和适应新的任务。

为了实现上述目标,推理强化学习阶段采用了以下方法:

1. 数据选择

选择高质量的训练数据是提升模型推理能力的关键。这一阶段的数据选择遵循以下标准:

数据来源:从长思维链冷启动阶段的数据集中选择未使用且具有挑战性的查询-验证对(query-verifier pairs)。

选择的数据必须满足以下四个标准:

- 未在冷启动阶段使用:确保数据的新颖性,避免模型在强化学习阶段重复学习。

- 冷启动模型可学习:选择冷启动阶段模型能够学习的数据,确保数据的可学习性。

- 尽可能具有挑战性:选择难度较高的数据,以提升模型的推理能力。

- 覆盖广泛子领域:确保数据覆盖多个子领域,提高模型的泛化能力。

最终收集了 3,995 个查询-验证对,用于强化学习阶段的训练。

2. 强化学习算法

选择合适的强化学习算法是提升模型性能的关键。这一阶段采用了 GRPO(Generalized Reinforcement Policy Optimization)算法。

- 样本效率:通过 off-policy 训练提高样本效率,减少训练成本。

- 探索和利用的平衡:通过控制模型的熵,确保训练过程的稳定性,同时允许模型在探索和利用之间找到平衡。

思维模式融合

在 Qwen3 模型的后训练阶段中,思维模式融合(Thinking Mode Fusion)阶段的目标是将“非思考模式”(non-thinking mode)的能力整合到已经具备“思考模式”(thinking mode)的模型中。这一阶段旨在使模型能够在两种模式之间灵活切换,从而在处理不同任务时能够根据需求动态调整其行为。具体目标包括:

- 模式整合:将“非思考模式”和“思考模式”整合到同一个模型中,使用户能够根据任务需求动态切换模式。

- 性能优化:确保模型在两种模式下都能表现出色,同时优化其在不同任务中的性能。

- 推理预算控制:引入推理预算机制,允许用户在推理过程中动态调整推理深度,从而在性能和延迟之间取得平衡。

为了实现上述目标,思维模式融合阶段采用了以下方法:

1. 数据集构建

在Thinking Model Fusion阶段,是在Reasoning RL的基础上,通过监督微调SFT实现。因此SFT训练数据非常关键。

思考数据构建

- 拒绝采样:通过Stage 2训练得到的推理模型,利用Stage 1的query进行拒绝采样(rejection sampling)生成“思考”数据。这种方法确保数据的质量和多样性,同时避免模型在训练过程中过度依赖特定的数据模式。

- 数据筛选:通过人工标注进一步筛选生成的“思考”数据,确保其准确性和相关性。

非思考数据

- 多样化任务覆盖:精心策划“非思考”数据,确保其涵盖多种任务,包括编程、数学、指令遵循、多语言任务、创意写作、问答和角色扮演等。特别增加了低资源语言的翻译任务比例,以提升模型在多语言任务中的表现。

- 质量评估:使用自动生成的检查表(checklists)评估“非思考”数据的响应质量,确保数据的准确性和相关性。

2. 聊天模板设计

为了支持用户动态切换模型的思考模式,设计了专门的聊天模板。通过在用户查询或系统消息中添加特定的标志,用户可以控制模型的行为。

模式切换标志

- /think 标志:用户可以在查询中添加/think标志,指示模型进入“思考模式”。这是模型的默认行为,因此在用户未明确指定时,模型也会默认运行在“思考模式”。

- /no think 标志:用户可以在查询中添加/no think标志,指示模型进入“非思考模式”。这允许用户在需要快速响应时禁用模型的思考能力。

内部一致性:即使在“非思考模式”下,模型也会保留一个空的思考块(<think>),以确保内部格式的一致性。开发者可以通过在聊天模板中添加空的思考块来防止模型进行思考。

3. 推理预算机制

为了进一步优化模型的性能,引入了推理预算机制。这一机制允许用户在推理过程中动态调整推理深度,从而在性能和延迟之间取得平衡。

通俗来说,只要用户设定了模型思考的最大长度限制,当思考达到该阈值时,就会手动插入一段停止指令(“Considering the limited time by the user, I have to give the solution based on the thinking directly now.\n</think>.\n\n”),终止进一步推理,让模型基于已完成的思考内容输出最终回答。

论文里强调,控制推理预算的能力并非通过显式训练获得,而是应用思维模式融合后自然涌现的。

通用强化学习

这一阶段的目标是通过广泛的强化学习任务,进一步提升模型在各种场景下的性能和稳定性。这一阶段的训练旨在:

- 提升模型的通用能力:使模型在多种任务中表现出色,包括指令遵循、格式遵循、偏好对齐、代理能力和特定场景能力。

- 优化模型的稳定性和适应性:通过多样化的任务和奖励机制,确保模型在不同场景下都能稳定运行。

- 增强模型的交互能力:特别是在长文本处理和多步骤决策任务中,提升模型的交互能力和决策效率。

为了实现上述目标,通用强化学习阶段采用了以下方法:

1. 任务设计

设计了超过 20 种不同的任务,涵盖多个领域和场景,以全面评估和提升模型的性能。这些任务包括:

- 指令遵循任务:确保模型能够准确理解和执行用户的指令,包括内容、格式、长度和结构化输出的要求。

- 格式遵循任务:要求模型能够根据特定的格式要求生成响应,例如处理/think和/no think标志。(控制模型混合思考模式的关键)

- 偏好对齐任务:提升模型在开放性问题上的表现,使其能够生成更自然、更符合用户偏好的回答。

- 代理能力任务:训练模型正确调用工具接口,通过与环境的交互反馈提升其在长决策任务中的表现。

- 特定场景任务:针对特定场景(如检索增强生成任务)设计任务,通过奖励信号引导模型生成准确且上下文相关的内容。

2. 奖励系统

为了指导模型的学习方向,设计了多种奖励机制,包括:

- 规则基础奖励(Rule-based Reward):适用于需要精确评估模型输出的任务,如指令遵循和格式遵循任务。这种奖励机制通过精心设计的规则可高精度评估模型输出的正确性,避免奖励欺骗问题。

- 基于模型的奖励(Model-based Reward):有参考答案的奖励:提供参考答案,让模型根据参考答案评估其响应的质量。这种方法适用于需要灵活处理的多样化任务,避免了因严格格式要求而产生的误判。无参考答案的奖励:利用人类偏好数据训练奖励模型,为模型的响应分配标量分数。这种方法不依赖参考答案,能够更广泛地处理各种查询,提升模型的交互性和帮助性。

强到弱蒸馏

这一阶段的目标是通过从大型模型(teacher models)向小型模型(student models)的知识传递,优化小型模型的性能,同时显著降低计算成本和开发工作量。这一阶段的训练旨在:

- 提升小型模型的性能:通过知识蒸馏,使小型模型能够继承大型模型的强大推理能力和多语言处理能力。

- 降低计算成本:减少小型模型的训练时间和资源消耗,使其在实际应用中更具成本效益。

- 保持灵活性:确保小型模型能够灵活切换“思考模式”和“非思考模式”,并根据任务需求动态调整推理深度。

为了实现上述目标,强到弱蒸馏阶段采用了以下方法:

- 离线蒸馏(Off-policy Distillation):在初始阶段,结合教师模型在 /think 和 /no_think 模式下生成的输出进行响应蒸馏,帮助轻量级学生模型发展基本推理技能和模式切换能力,为下一阶段的在线训练奠定基础。

- 在线蒸馏(On-policy Distillation):在此阶段,学生模型生成在线序列进行微调。具体而言,采样提示词后,学生模型以 /think 或 /no_think 模式生成响应,随后通过对齐其对数(logits)与教师模型(Qwen3-32B 或 Qwen3-235B-A22B)的对数来微调学生模型,以最小化 KL 散度。

后训练评估

1.旗舰模型

Qwen3-235B-A22B 在思维和非思维模式下均展现了开源模型中的 SOTA 整体性能,超越 DeepSeek-R1 和 DeepSeek-V3 等强基线,且与 OpenAI-o1、Gemini2.5-Pro 和 GPT-4o 等闭源领先模型具有高度竞争力,彰显了其深厚的推理能力和综合通用能力。

2.旗舰稠密模型

Qwen3-32B 在大多数基准上超越了此前最强的推理模型 QwQ-32B,性能与闭源的 OpenAI-o3-mini 相当,体现了其强大的推理能力。Qwen3-32B 在非思维模式下的表现也非常出色,超越了阿里上一代旗舰模型Qwen2.5-72B-Instruct。

3.轻量级模型(包括 Qwen3-30B-A3B、Qwen3-14B 和其他较小的稠密模型)相比参数规模相近或更大的开源模型持续表现出更优性能,证明强到弱蒸馏方法的成功。

4.消融实验思维预算的影响:通过在数学、编程和 STEM 领域的多个基准测试中调整推理预算,Qwen3 模型展示了其性能与分配的推理预算成正比。具体来说,随着思考 token 预算增加(16K→32K),Qwen3-235B-A22B 在 AIME’24、LiveCodeBench 等任务中的性能呈线性提升,证明模型可通过分配更多计算资源提升复杂推理能力。

在线蒸馏的有效性与效率:与直接进行强化学习相比,**使用强到弱蒸馏方法训练小型模型在性能和训练效率方面具有显著优势。**具体来说,蒸馏方法不仅提升了小型模型的性能,还大幅减少了训练所需的 GPU 小时数。对比 RL 和蒸馏:在 Qwen3-8B 上,仅用 1/10 GPU 小时的蒸馏训练即可使 AIME’24 得分从 55.0(离线蒸馏)提升至 74.4(在线蒸馏),远超 RL 的 67.6 分。蒸馏还显著提升探索能力(Pass@64 从 90.0→93.3),而 RL 未带来此改进。

推理模式融合的效果:通过在后训练阶段引入推理模式融合和通用强化学习,Qwen3 模型在多种任务中的表现得到了显著提升。具体来说,模型在指令遵循、格式遵循、偏好对齐和多语言任务中的表现尤为突出。注:虽然在一些复杂任务(如 AIME’24 和 LiveCodeBench)中,模型在“思考模式”下的性能在经过通用强化学习后有所下降,但这是为了提升模型在更广泛任务中的通用性和适应性所做出的权衡。

4、总结

Qwen3 大模型通过创新的架构设计、高效的训练策略和独特的后训练流程,在性能、效率和通用性上实现了重大突破。无论是处理复杂推理任务,还是应对多语言需求,Qwen3 都展现出强大的实力。随着开源社区的共同努力,相信 Qwen3 将不断进化,为人工智能的发展带来更多惊喜,也期待它在更多领域发挥作用。