“没有高性能计算,就没有大模型。”

自 2023 年以来,伴随大模型崛起的除了芯片,还有芯片与模型之间的中间层——系统软件优化,其中高性能计算(HPC)背景出身的研究员参与占比大幅攀升。但对大众来说,HPC 之于 LLM 的战略意义仍是晦涩艰深的,直到 DeepSeek 杀出重围,软硬协同的力量被具象化,他们才被更多关注。

事实上,早在中国大模型的研究历史初期,HPC 科学家的身影就占了一席之地。2020 年 10 月国庆前后,智源为研究大模型购入十台英伟达 v100,就是清华高性能计算研究所的团队前去帮忙搭建。悟道算法团队用这个小集群训练了中国最早的大规模预训练语言模型 CPM,韩旭也参与其中,切身体会了 HPC 的分量。

芯片厂商卖卡通常只提供一整套机房设计方案的说明书,具体搭建还需要专门的系统人才。而将机器搭起来、到通过上层软件编写让机器更快跑起来、再到大模型训练时将大规模参数的存储与计算分摊到各个机器上、并解决机器与机器之间的通信问题,使模型训练地又好又快,每一步都属于高性能计算的知识范畴。

以计算为例。大模型的计算是算矩阵乘法(即“算子”),矩阵乘法的计算是一个矩阵一个矩阵地算,大模型的参数规模大,计算矩阵时也要切成不同大小,以 100x100 的矩阵为例,在计算时是将其切成十横十竖、还是斜对角切,算出来的结果也会不一样——虽然切法可以穷尽,但每改一次就会牵一发动全身,大模型训练即使单次试错也成本不低。

因此,尽管不是一门新学科,但在中间层降本增效的 HPC 技术在大模型时代天然就扮演了核心角色。

中国的 HPC 发展经历了三个主要阶段:从上世纪七八十年代自研或仿制计算机(如 DJS 系列计算机、 银河、神州超级计算机等),到九十年代抛弃大规模复杂硬件工程,转向直接从外部采购工作站、研究硬件上的可扩展软件系统,再到 21 世纪后超算三大家(曙光公司、国防科大与江南计算所)开始用自研处理器、芯片构建超级计算机。

这当中,第二个阶段是中国 HPC 发展的一个关键转折点,而清华高性能计算研究所(以下简称“高性能所”)扮演了先驱角色之一。

上世纪九十年代,他们率先放弃从零开始、每块 CPU 每台机器都要自研的路线,从外部采购了多台工作站,通过高速网络将其连接在一起、再将工作站上的并行计算软件搭好,组成了高性能计算机(又称“集群系统”),效果很好。之后中国的 HPC 研究开始腾飞,打破了美国与日本的垄断局面。

相比其他院校,如中科院计算所、国防科大等单位能投入千人规模研究,清华的性质决定了其在 HPC 上无法投入大量人力,于是 1999 年高性能所成立后,研究重点也转向了面向大规模集群系统的软件优化与应用,在面向大规模集群的计算、存储与通信问题中积累了丰富的经验。

这也使得,过去的 25 年间,清华高性能所在 HPC、大数据、云计算、人工智能浪潮中均能屹立不倒。例如,大模型有 5 个关键环节:数据获取、数据预处理、训练、微调与推理,计算、存储与通信几乎贯穿了每个环节。

而高性能所在历经多个浪潮后仍能历久弥新,还要从一个人的故事说起,他就是中国 HPC 与存储领域的著名科学家:郑纬民。

一、继往开来

郑纬民的研究起点,是 24 岁在清华西主楼一区四层的并行/分布实验室,见过 PDP-1/23、03 等当时最好的计算机,以及其他小型计算机、S-1280 等计算机。

那是上世纪七十年代,动荡的岁月还未结束,但在这个小小的实验室里,一个青年技术员却看到了技术变革的光辉。从此,他的一生都与研究计算机绑在了一起。

或许是时代命运与个人视野的反差,郑纬民在后来并没有成为一个大众刻板印象中的科学家。在他的身上,两种冲突的特征得到天然的融合:在科学研究中,他有着技术人员对技术创新的普遍严谨与敬畏;但生活里,郑纬民却并不沉默寡言,而是常常开怀大笑、高谈阔论,声音洪亮不输年轻学生。

谈及大学时代的波折,也只有简单的一句“专业稍有荒废”。

1965 年,郑纬民从浙江宁波考到北京,成为了清华大学自动控制系(今清华计算机系的前身)的一名本科生。没多久文化大革命爆发,郑纬民的学业也受到影响,计算机相关理论与专业知识基本靠自学。好在运气不错,1970 年郑纬民顺利毕业,并留校任教加入了清华计算机大教研组,从助教做起。

1978 年,计算机大教研组被拆分成计算机系统结构、计算机系统及应用、微型计算机三个教研组,郑纬民被分到了计算机系统及应用组中。那时郑纬民 30 出头,好学心还是很大,想解决更难的问题,但深感专业基础不扎实的掣肘,于是 1979 年又去读了清华计算机系的硕士。

1982 年硕士毕业后,郑纬民又分别到美国、英国访问了一段时间,先后在美国纽约州立大学石溪分校与英国南安普顿大学当研究员。这两段海外经历大大拓宽了他的研究视野,提升了他对计算机体系结构的专业理解,同时也将他的研究品味从“跟上国际顶尖”转向了“超越国际顶尖”。

郑纬民

回国没多久,郑纬民就接任了计算机系统及应用教研组的主任一职,开始参与清华的大规模计算集群系统(cluster)研究,即高性能计算机。

原先国内研究 HPC 是从零开始,耗时长、成本高。郑纬民等人尝试一段时间后,果断放弃,从外部直接采购了多台计算力强的工作站、将其连接起来,1996 年做出了国内最早的微机集群系统——清华同方探索 108,并将其推向市场,在 1999 年国庆 50 周年庆祝活动中用于北京市气象局的天气保障。

由于贡献突出,郑纬民等人获得国家科技进步二等奖。

也是在 1999 年,清华进行组织架构改革,将计算机系统及应用、微型计算机两个教研组合并成了高性能计算技术研究所,首任所长由时任清华计算机系主任的周立柱教授兼任,2000 年郑纬民接任。

郑纬民当所长后,继续主导并成功研制了一系列集群计算机。但随着集群计算机的研发越来越复杂,要求投入的人力规模也越来越大,HPC 的研究主力就从高校转向了国家专门成立的超算中心与大型研究所。清华高性能所在郑纬民的带领下,逐渐转向 HPC 应用与系统结构优化,以软件开发为主。

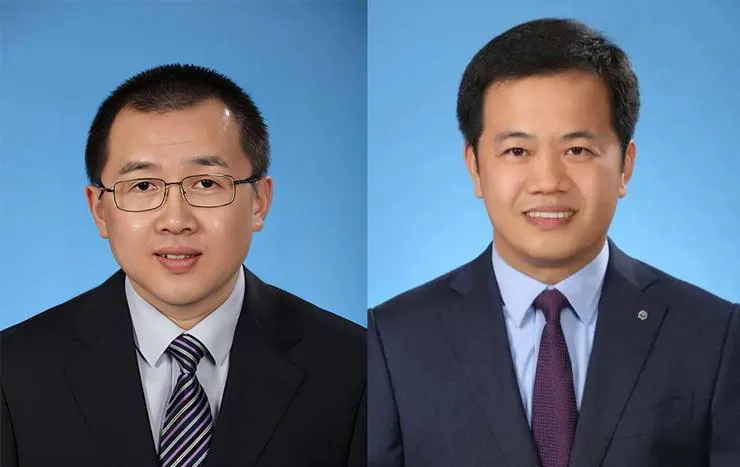

杨广文与薛巍分别是 1996 年、2003 年到郑纬民组当博士后,也历经了这一转折期。他们后来将 HPC 应用于解决大规模的科学计算问题,一共获得过两次全球高性能计算领域最高奖——戈登贝尔奖,一次是天气预报,另一次是地震模拟,分别在 2016、2017 年,其中 2016 年是中国首次获奖。

杨广文 2004 年接任高性能所所长,此后又担任无锡超算中心主任,其主导运维的“神威·太湖之光”超级计算机是中国超算的骄傲。杨广文团队为其研发了应用支撑系统,取得多项领先成果。Top500 榜单是评选全球“最快”超级计算机的 500 强,中国曾有三台超级计算机是世界“第一”,神威·太湖之光就是其中之一、2016 年登上 Top500 榜首。

杨广文(左)与薛巍(右)

HPC 从一开始就是为了解决大规模的计算需求而生,而许多关乎国计民生的问题求解都依赖大规模的计算。

以天气预报为例,天气预报具有强时效性,同时一个地区(如北京)的天气预测往往要划分为多个不同的区域(如海淀、朝阳、丰台等)进行计算,因此计算量极大。计算规模大,同时要求计算速度快、计算精度高——这只有超级计算机能解决。

一开始,计算机系统结构的优化以计算为主,但随着计算机的普及与互联网的发展,数据变得愈发重要。郑纬民敏锐地察觉到了这一变化,预感未来系统结构的研究会从“以计算为中心”转向“以存储为中心”,因为数据处理的前提是数据的存储。

于是,郑纬民开始将团队的研究重心从传统 HPC 转向了存储。

在郑纬民之前,国内没有大型存储,技术被海外垄断、价格也居高不下。郑纬民带领团队里的舒继武、薛巍等人攻克了这个难题:他们从 0 到 1 突破,在国内首次研究出可扩展的大规模存储区域网络(Storage Area Network,SAN),将大规模 SAN 存储的产品价格打了下来。

除了大规模 SAN 存储外,郑纬民还曾创新性地提出社区共享的云存储思路(如今云盘技术的基本原理),并主持开发了国内首个云计算平台“清华云”。

2006 年,郑纬民团队余宏亮的研究论文被计算机系统顶会 Eurosys 接收,是中国大陆学者首次在 Eurosys 上发表的论文。2011 年,郑纬民团队的工作 FastScale 又被全球计算机存储顶会 FAST 接收,是国内高校在 FAST 上独立发表的首篇文章。

在郑纬民之后,十数年间,高性能所的团队在系统方向又获得多个“大陆第一”,包括:国内大学首篇 OSDI 顶会论文、国内首次跻身 IO500(全球存储 500 强排名)榜首等;甚至“国际首次”,如全球第一个提出 Open_Channel 闪存存储。

分别在 1999、2002 年到郑纬民组当博士后的舒继武与武永卫,是最早跟着郑纬民研究存储的青年学生,后来也成为了存储方向的接班人。如今清华高性能所是中国计算机存储的佼佼者,在闪存、分布式内存、分离式内存与分布式文件系统等领域均有突出成果,其余星星点点的技术突破更是不计其数。

舒继武(左)与武永卫(右)

虽然高性能所的研究内容从集群转向了软件,但与硬件的关系一直十分紧密。这是因为,面向系统结构优化的软件编写天然就要求研究者熟悉底层的硬件环境,包括计算机与芯片本身。同样是以天气预报为例:

二十年前,郑纬民团队用 HPC 研究天气预报,跑在计算机上的程序实际是天气预报专业的人写的——当时计算机结构还比较简单,他们只需要懂 C 语言和 MPI(一个跨语言的通信协议)就能写出优秀的天气预报软件。但近几年这个模式走不通了,因为现在的计算机结构变得更复杂,如果只懂这两样、不懂机器,写出来的软件性能会大打折扣。

可以说,“软硬协同”是写在清华高性能所基因里的一个研究思想。

原先郑纬民在清华上两门课,一门是面向本科生的《计算机系统结构》、还有一门是面向研究生的《高级计算机系统结构》,许多系统研究方向的学生都是通过这两门课的教材与 PPT 入门。但选择系统方向的学生既要懂硬件,又要懂软件,还要有超强的写代码能力,即使是清华学生也常考低分。

这也注定了系统研究是一个独孤求败的赛道。系统结构领域的顶会一年所接收论文最多不超过 300 篇,据郑纬民的说法,“高性能所的老师平均每人每年只能招 0.7 个博士生、有时候一年也招不到”。但同时,这又是一个极具决定意义的技术方向,所以高性能所每培养一个硕博生,基本都被国内大厂哄抢。

郑纬民所培养的学生,除了留在清华任教的学者,进入工业界的还有华为海思首席科学家廖恒、网易有道 CEO 周枫、美团首席科学家夏华夏等等,国内系统架构方向的顶尖人才很多都与郑纬民或多或少有关。此外,郑纬民的学生还有对标 lululemon 瑜伽服品牌 Halara 的创始人张小沛等等,每个人的发展并不局限。

少为人知的是,DeepSeek 主导软硬协同设计的核心成员中,就有 4 位从清华高性能所走出的青年学生。

此前,HPC 科学家并不活跃在聚光灯下。超级计算机虽是国家重器,却距离大众太远。近两年,大模型家喻户晓,在大模型硝烟中扮演“特种兵”的 Infra 人才也被推到了台前。尤其是 DeepSeek 出圈后,更多人看到了系统优化的价值——大模型突破的关键,不只在算法层,还有系统层。

二、一个新的计算 workload

2015 年,翟季冬去斯坦福大学访问了一年,那是他第一次直观感受到人工智能的浪潮。

当时,位于湾区的两大计算机顶尖高校斯坦福和伯克利都在如火如荼地开展 AI 研究,从算法到 Infra。于是 2016 年回国后,他也将研究方向从传统的科学计算转向了 AI 系统软件。

那是卷积为王的时代。当时商汤刚起步,在清华附近也有办公室,翟季冬团队与商汤建立了合作关系,研究如何将卷积模型训练地更好、推理跑得更快。但卷积类模型对计算的需求远没有大模型那么高,大模型训练需要成百上千张加速卡,而卷积模型一般只要 8 张、16 张,所以他们当时开展的是小规模的训推优化。

在翟季冬看来,HPC 的研究本质一直没有变,都是关注如何把跑在计算机上的程序优化地更快、更好,“只是上面的应用负载(workload)变了”,从天气预报程序变成了人工智能程序。

翟季冬的本科毕业于电子科技大学,2003 年以年级第一的成绩保送到清华。那时他有两个读博方向可选,一个是人工智能所,另一个是高性能所。相比算法,翟季冬更喜欢需要编程、偏系统的高性能计算,几乎刹那之间就选择了HPC——“在给定硬件上探索怎么把一个程序的性能发挥到极致”,这个话题特别吸引翟季冬。

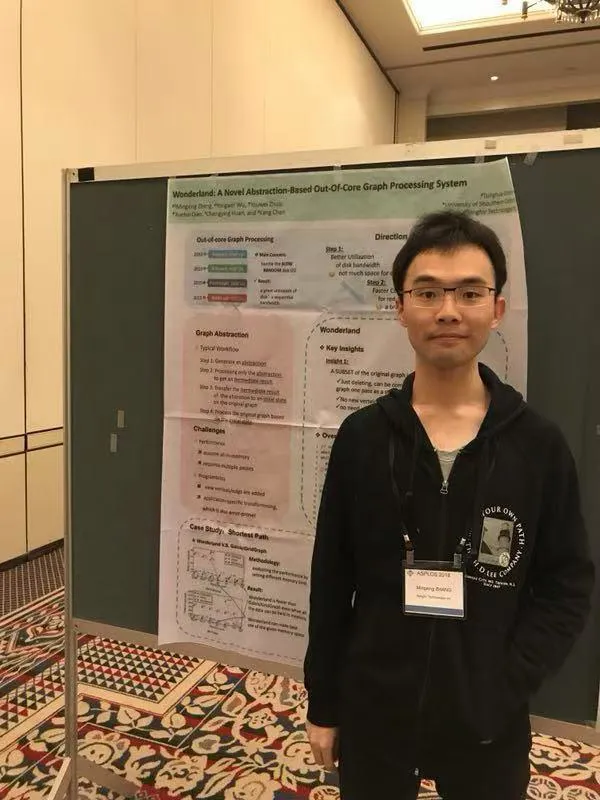

翟季冬

入学后,翟季冬跟着郑纬民和陈文光读博。陈文光也是郑纬民的博士生,那一年刚从外面结束创业、回清华当老师,由于还没有博士招生资格,就帮着郑纬民带学生,在具体研究上给了翟季冬许多指导,所以翟季冬也一直将陈文光视为博士期间的导师。

与翟季冬不同,陈文光选择 HPC 是偶然:

陈文光的中学就读于清华附中,那时班上有位同学的父亲是清华的王克宏老师,王克宏当时正在研究 AI,陈文光很感兴趣,于是 1990 年入读清华后就开始跟着王克宏、石纯一研究 AI。但大四推研时,这两位老师都没有招生名额了,王鼎兴和郑纬民组还有,于是陈文光就去了郑纬民组读博,由此进入了高性能计算领域。

读博期间,陈文光研究的是面向大规模集群系统的自动并行编译器。不过,当时陈文光的志向并不在科研,而是一心想创业,所以博士毕业后就没有选择留校,而是投入了互联网的创业大军中,面向 C 端用户开发用于不同平台购物比较的软件。

但这个模式只适用于类似书这样的标准商品。互联网泡沫破裂后他们靠着外包软件开发支撑了几年,终不是长久之计。刚好当时国内兴起自研国产 CPU 的热潮,陈文光想既然有 CPU 了、那就肯定需要编译器——编译器的作用是将上层应用的程序代码转成底下芯片上能运行的机器代码,于是重新加入了高性能所。

担任教职后,陈文光继续在自动并行编译上做了大量探索,同时拓展到串行编译器的性能优化,但很快发现这块的研究已接近天花板:

2010 年,他们的一个编译器工作被编译顶会 PLDI 接收,结果却让陈文光十分灰心,因为虽然他们在这个编译器上写了大量复杂的代码,整体性能优化却只提升了 1%。于是 2010 年之后,陈文光就不再局限于编译器,而是往上一层看,转向了图计算的研究。

陈文光

受导师郑纬民的影响,陈文光一直以“做出有全球影响力的工作”的目标来要求自己,不甘于现状。在带翟季冬的时候,陈文光也经常跟他强调,不要追求论文数量,而是要做有用的研究。郑纬民教做人做事,陈文光教研究品味,所以翟季冬从博士期间就开始了对自己的高要求。

读博时,翟季冬主要研究高性能计算机的性能评测。当时高性能所有一个国家项目,主要是对国内研制的大规模机器性能(包括网络、通信与内存)做评测,一般是成百上千台的规模、跟现在的大规模数据中心类似。这就要求有一套完整的评测理论与方法。翟季冬的博士论文就是写 HPC 性能预测,用一台机器预测出更大规模机器上的程序性能。

博士毕业后,翟季冬完全没考虑过工业界的机会,连简历都没有投过,而是留校当了两年博士后,2012 年开始当教职。他先是与薛巍一起研究如何在国产高性能计算机(如“神威蓝光”)上让天气预报等应用程序跑得更快,之后又在 2014 年开始接手了清华的学生超算竞赛团队。

在翟季冬的带领下,清华超算第二年就开始开挂——2015 年同时获得三大超算比赛 SC、ISC 与 ASC 的冠军,2018 年又再度获得大满贯。截至目前,清华一共在超算比赛中夺冠 18 次,翟季冬带队时就获得过 15 次。

全球三大超算比赛面向本科生,比赛内容是在一个小规模的集群上给定一些题目,在同等功耗限制下看谁跑得快,本质上考核参赛者对计算机性能分析与优化的能力。因此,打过超算比赛的学生在 HPC 相关基础知识上也会更扎实。许多参赛学生如谢磊、唐适之、何家傲、郑立言、黄可钊在本科毕业后都继续跟着翟季冬读博,在翟季冬转向“HPC+AI”后也在这个方向做了深耕。

值得注意的是,DeepSeek 大模型 Infra 的核心成员赵成钢在清华读本科时也是超算团队的学生,在翟季冬的指导下三次夺冠。

赵成钢的硕士是在清华叉院读,主攻 Infra 框架层的系统优化软件开发,2024 年硕士毕业,翟季冬也是他的硕士答辩委员。翟季冬记得当时问他“准备去哪工作”,赵成钢说“去 DeepSeek 研究 AI 框架”,当时翟季冬还有些意外,因为没听过这家公司,但他认可赵成钢所选的方向是十分重要的。

翟季冬在 2017 年转向 AI 系统软件开发时,恰逢新浪潮的萌芽期:那一年,Transformer 诞生,2018 年谷歌又基于 Transformer 发布了 BERT,引起广泛关注,翟季冬团队也开始关注。那时候,他们也探索了围绕 Transformer 的系统优化,包括底层的编译。

但 Transformer 的出现并没有立即改变 AI 对 HPC 的低诉求。翟季冬团队虽有探索,也因处在技术生涩期而走了不少弯路。所以在传统计算探索多年后、寻找下一个计算 workload 时,清华高性能所的年轻教授反而将目光转向了图计算,而非 AI。

2012 年前后,社交网络的兴起催生了大规模的图分析需求。图计算也涉及到上百台机器集群的运转,要解决底层系统的数据丢失与容错、负载均衡等问题。那时高性能所有两个团队涉及图计算,陈文光组与武永卫组,不过两个组是分开研究,武永卫组从系统存储切入,陈文光从编译器切入。

受谷歌 MapReduce(专门针对大规模数据集的编程模型)自动并行的思路启发,陈文光与团队从数据结构、调度负载均衡及并行计算等 HPC 方法论,分别在 2015、2016 年提出了针对图计算的单机图处理引擎 GridGraph 与分布式系统双子星,计算速度都是当时的 SOTA。尤其是双子星,速度比当时 CMU 推出的高性能分布式图并行计算框架 PowerGraph 还要快几乎 20 倍。

陈文光一直有个目标,就是开发出能被全世界广泛使用的软件,像伯克利的 PostgreSQL、Apache Spark 等一样。它们的路径都是先开源,然后孵化公司、做成系统在全世界推广。于是 2016 年陈文光又萌生了创业的念头,拉了他的四位学生——洪春涛、朱晓伟、林恒、李恺威,在北京创立了费马科技。

2020 年,费马科技被蚂蚁集团以数亿人民币的价格收购——这次收购主要是对人才的收购,因为蚂蚁聚焦支付贷款,整个大场景是金融风控,对图计算有大量需求。被收购后,费马团队一同并入蚂蚁集团,包括陈文光。2022 年,陈文光还被任命为蚂蚁技术研究院院长。

为了避免清华与蚂蚁之间的产权冲突,2020 年被收购后,陈文光开始为学校科研寻找图计算以外的研究方向。也是在这一年,AI 与 HPC 的缘分终于降临——秋天,陈文光团队受智源邀请去搭建机器,以支持一个新的计算 workload:

大模型。

三、一支“特种兵”

1024 张 A100 是什么概念?

今天许多 AI 算法研究员已经对这个数字见怪不怪,但 2020 年 OpenAI 宣称 GPT-3 的训练用 1024 张英伟达 A100 跑了 34 天时,所有人都震惊了。然而,这个数字在超算面前却是“小巫见大巫”。

以神威·太湖之光为例,其由 40 个运算机柜组成,每个机柜包含 1024 块处理器——也就是说,从大的机器规模上来看,支撑 GPT-3 的集群只是神威·太湖之光超算的 1/40。因此,清华算法团队在决定研究大模型后,首先就想到了大模型背后庞大计算集群的缔造者们——清华高性能所。

2020 年 10 月,陈文光团队的助理研究员韩文弢率先被邀请到智源搭建十台英伟达 v100,同行的还有高性能所的几位学生,曹焕琦、陈晟祺、李岱轩与孙桢波。

这台小规模的机器集群支持刘知远团队完成了预训练语言模型 CPM,不过 CPM 的参数规模只有几十亿,所以高性能所的支持没有延伸到更广的系统优化上,而是停留在机器搭建,韩文弢后来也没有投身大模型,而是回归了教职主业。

韩文弢

陈文光与翟季冬真正投身大模型,是 2021 年与唐杰、杨红霞等人一起在国产超级计算机上训练百万亿参数 MoE 大模型。为此,他们主力开发了“八卦炉”大模型训练系统。

他们选中的超算在山东。那时候,新一代神威机器即将竣工,也需要新的程序来测试。2021 年 1 月,翟季冬与杨红霞就带了高性能所的马子轩、何家傲等学生去现场考察,当时,支撑大模型训练的软件非常不足,无法支撑训练任务。"几乎什么都没有",从上层的并行框架、中间层的PyTorch到底层的算子库——基本等于赤手空拳。加上之前超算没有用来训练过大模型,所以大家心里都没底。

陈文光与翟季冬的学生从 2 月开始驻场,从底层算子编译做起,到并行通信、大规模并行计算软件编写,搭建了一整套八卦炉系统,中间遇上春节假期也几乎没有休息,最终在 5 月份将包含 174 万亿参数的 MoE 模型在超算整机上跑了起来。

在这个过程中,清华高性能所团队的最大收获不是诞生了多少创新的 idea,而是掌握了大模型的整体训练流程。

在智源的万亿级参数大模型中,高性能所的贡献主要是算子的编写优化与训练框架设计。

通俗来说,编写并行程序时,通常要告知系统哪些部分可以并行、如何并行,以及训练过程中怎么处理出错情况和平衡机器负载等问题,整个过程需要编写大量的代码。通过软件优化后的“八卦炉”大模型训练系统只需要简单的任务描述,就能让万亿大模型在青岛超算中心包含 10 万个 CPU、4000 多万个核的大型机器上高效运行。

HPC 的本质是追求更快、更极致的计算性能,通过“榨干”底层的硬件潜力支持机器上层的训练程序。“更快”就意味着“更省”——在相同的硬件条件下,假设大模型的训练时间能从一小时缩短至十分钟,那就相当于节省了五十分钟的算力消耗成本。这个真实存在的需求目标很吸引翟季冬。

也是在参与悟道项目后,翟季冬发现 MoE 架构的大模型训练还有很大的优化空间。

2021 年 1 月,翟季冬团队里的博士生何家傲就开始研究 FastMoE。

当时他们发现,MoE 模型相较其他的深度学习模型有天然的独特之处,主流框架如 PyTorch 原生不支持 MoE 模型的训练,于是就想开发一个专门的 MoE 框架,在 PyTorch 里加一两行代码就能让 MoE 模型自动跑起来。何家傲耗时大约两个月将 FastMoE 完成并开源,是全球第一个开源的 MoE 训练框架,在社区里引起非常不错的反响,被腾讯、华为等多个团队引用。

FastMoE 实现了许多功能,但在自动并行等问题上还不够出色。2022 年,翟季冬的另一个博士生翟明书基于 FastMoE 做改进,设置了一个在线与离线结合的并行策略选择,提出了 SmartMoE。

简单来说,大模型在训练前需要分析采用什么样的并行策略可以提高模型的训练效率。针对这一步骤,此前稠密模型已有 Alpa 等工作支持,但 MoE 是稀疏模型、具有动态性,即 MoE 模型在纯静态时所选的并行策略并不一定最优。对此,SmartMoE 选择了在线与离线结合:静态时先选择一组不错的候选集合,比如大约 10 组配置,然后在大模型真正训练时在这 10 组中灵活调整到最优。

这两个工作的思路后来都被行业广泛引用,但其开始的时间都远远早于行业热捧 MoE 之前。

除了 MoE,翟季冬团队也针对稠密模型的推理做过系统优化,提出了编译器 PET 与 EinNet 等工作。但相比 MoE,稠密模型的性能极限已在业内形成共识,而 MoE 架构的稀疏激活和负载动态性对整体训练优化来说依然非常难,因此从系统的角度看,优化空间更大。

2016 年翟季冬去斯坦福访问,曾见识硅谷高校的顶尖科学家并不囿于高墙。比如,斯坦福的多核处理器专家 Kunle Olukotun 在学校研究出很好的技术后创立 Afara 芯片公司,后来被 Sun 收购、自己也评选上了美国工程院院士。这让翟季冬一直相信,创新与创业并不割裂。

于是 2023 年大模型爆发后,翟季冬看到大模型对中间层软件的需求,就拉着汤雄超、师天麾、唐适之等几位学生一起创立了大模型 Infra 公司“清程极智”,推出了“赤兔”大模型推理引擎等工作。

八卦炉以训练为主,赤兔以推理为主。当前大模型领域两个主流的开源推理引擎 vLLM 与 SGLang 都由伯克利团队开发,对国产芯片的支持效果不好,而随着国产芯片的崛起,将国产芯片用于大模型的推理支持是大势所趋。清程极智所开发的“赤兔”系统经试验,能大幅降低 DeepSeek 等多个国产大模型的推理成本。

2021 年支持完悟道后,陈文光也选择在国产大模型基础设施上更进一步,一方面兼任鹏城实验室智能计算研究部主任,主导“云脑 2”上大型并行训练系统搭建;另一方面是开发通用大数据处理优化系统,发布了“诸葛弩”等成果。

云脑 2 的特点是基于 4096 张华为昇腾 910A 卡打造而成,总算力规模为 1 Eops@FP16,存在精度支持不足、显存较小、卡间通信带宽较低等问题——这也是国产芯片集群的通用问题,在系统优化上主要有 3 个难点:一是要基于全新的昇腾 910A 卡打造高性能的 AI 处理器,二是要将 4096 张卡互联起来,三是整机系统的容错率与故障率把控。

陈文光与团队的任务是提高大模型在云脑 2 上的训练效率。总体来说,云脑 2 的设计与优化是成功的:

在芯片上,910A 的推出时间早于 A100,峰值速度是 256T、相当于 A100 的 0.8 倍。卡间互连上,910A 的卡间带宽只有 180GB/s,远低于 A100 的 600GB/s,后续的 910B 做了改进、提升到约 400GB/s 以上。此外,云脑 2 采取液冷系统,在 3000 多张卡上训练大模型时平均故障时间约为 100 小时一次,故障率约为风冷的 A100 系统的 1/10。

云脑 2 完成后,曾用于训练 2000 亿参数规模的纯文本稠密模型,但效果并不算出色,原因是训练数据不够,当时只训练了 1.8T token 数据。

一方面,大模型圈一直流行训练数据即将匮乏、耗尽的声音,但另一方面,又有观点认为,当前模型能力不理想的原因之一是特定领域的数据没有挖掘到,所以数据收集与处理仍是当前大模型基础研究的关键。

如今大模型的训练数据量越来越大,今年发布的 Llama 4 已达到 30T token、Qwen 3 达到了 35T token,但现有的通用大数据处理系统仍不尽理想。以 Spark 为例,虽然性能比 MapReduce 好,但基于 Java 的设计导致了大量内存冗余、计算效率低下。

陈文光从并行编程切入,将 Java 转为本地代码执行,开发了“诸葛弩”系统——像诸葛亮发明的弩一样,一次性射出多根箭,可以对数据快速去重、去广告与统一格式,数据处理效率较 Spark 提升了数倍以上。如今,陈文光也成立了数据处理方向的创业公司。

四、存储宝刀不老

大模型初期,清华高性能所团队从并行处理与编译出发,主要解决大模型的训练优化问题。2023 年 ChatGPT 出圈后,更多 HPC 学者关注到这一计算 workload,以存储为中心的系统优化开始在大模型领域崭露头角。

2024 年,武永卫团队发表了两个大模型推理优化的工作——Mooncake 与 KTransformers,最先拔得头筹。值得注意的是,这两个工作的背后有一位共同主导者,他就是 90 后青年科学家章明星。

章明星

章明星 2012 年本科毕业于北京邮电大学,大学期间打过 ACM/ICPC 比赛,对榨干硬件潜力的底层技术有深厚兴趣,于是直博推免时就自然而然地选择了高性能计算,在武永卫组研究图计算的分布式系统。

2017 年博士毕业后,章明星加入深信服,才开始接触机器学习系统,如用大规模机器学习研究杀毒软件。他在深信服工作了 5 年,涉猎多个业务线,最后发现自己还是最喜欢研究前沿系统的效率优化问题,于是 2022 年就选择了回清华任教。

没多久 ChatGPT 爆火,亲自上手体验后,章明星直觉这是一个颠覆性的技术方向。刚好杨植麟、张宇韬等人在筹备月之暗面,他们认为大模型的算法与 Infra 同等重要,想找系统方向的人才合作。张宇韬与章明星是江西南昌老乡,又是高中同学加博士校友,于是就找到了章明星,双方一拍即合。

2023 年年初,章明星以友情合作的身份参与到月之暗面 Infra 系统与团队的建设中,经历了从云厂商选型到后续模型训练与推理的全过程。

这是他第一次接触深度学习模型。章明星从 CUDA 算子怎么写、DeepSpeed/Megatron 系统怎么调试开始学习,与月之暗面的算法团队一起 babysit 炼丹炉,Mooncake 系统与 KTransformers 利用 AMX 指令的早期思路也是在这一合作的过程中诞生,主要用于模型的推理提效。

Mooncake 的诞生初衷很简单:

在大模型的实际使用中,假设一个用户用大模型看论文,并提问“这篇论文的三个主要创新点是什么”,之后大量用户也输入同样的论文与提问,那么这些问题的许多中间处理结果(KVCache)实际是相同的。

针对大模型的重复推理,Mooncake 的思路是将不同用户的相同 KVCache 公共部分存起来,到下一次需要用到时就直接换入到 GPU 中去、从而跳过这一部分的计算,通过廉价的存储置换了昂贵且稀缺的 GPU 资源,这一套“以存换算”的思想可以大幅度节省算力消耗。

Mooncake 发布后,影响很大。此前,虽然微软和北大等团队也针对大模型推理对算力的消耗提出类似思路并进行了早期探索,但 Mooncake 能在一众工作中脱颖而出的原因是:它第一次将 PD 分离和全局 KVCache 共享在大规模集群(数千张卡的规模)上跑了起来,拿到了真实的业务收益。加上 2024 年 kimi 有一波现象级的爆火,承载 kimi 的 Mooncake 系统也就跟着火了起来。

后来,Mooncake 在月之暗面内部得到更广泛的应用,包括支撑了 K1.5 和 K2 模型的强化学习后训练和推理。2024 年年中,他们将 Mooncake 的关键组件开源,吸引了包括 9#AISoft、阿里、蚂蚁、讯飞、字节、华为在内的国内基础设施厂商和研究团队一同建设,打造了一个开源的分布式推理社区。

在国际上,Mooncake 也引发了巨大反响:两大推理引擎 vLLM 与 SGLang 都通过与 Mooncake 合作进行分布式推理能力的建设,英伟达 Dynamo 系统也借鉴了 Mooncake 架构,此外英伟达还同 Mooncake、SGLang 社区一同在 H100 和 GB200 NVL72 的集群上复现了 DeepSeek 的高效分布式推理架构。

Mooncake 是面向超大规模集群的云上推理优化,KTransformers 则是为了解决大模型在本地化部署中显存不足的推理优化需求。

大模型在推理时主要用的是 GPU 推理卡,推理卡里包含两块区域:一块是计算、一块是存储。其中,存储区域叫“显存”,里面主要放两部分数据:一部分是大模型训练完以后的参数,另一部分是一步步推理过程的中间部署"KVCache”,所以需要大量的存储。这也是为什么在过去,将一个 671B 的 DeepSeek V3 大模型装进个人机器是非常困难的,因为显存非常昂贵。

为了解决这一问题,武永卫、章明星团队和趋境科技一同设计的 KTransformers 系统通过充分发挥本地广泛存在的廉价 CPU/DRAM 资源,借用显卡之外、主机里也有的存储 (如 CPU/内存),通过让 CPU 与 GPU 交换共同推理,实现了 400GB 内存的 CPU 再加一张英伟达的 4090 卡就能做到每秒 20 到 30 个 token 的输出。

由于正值全民探索 DeepSeek 的热潮,KTransformers 系统的热度也随之暴涨,成为了目前本地推理大型稀疏模型最主要的,以及后续 Qwen3 和 Kimi K2 模型首发推荐的本地推理框架之一。

Mooncake 与 KTransformers 的特点是:它们都是一套系统,而非一个技术单点。系统就意味着可以无限做深、持续优化,任何技术点都可以为系统所用。例如,在设计 Mooncake 时,章明星也用到了传统为高性能存储和数据库设计的 RDMA 等高性能通信技术。

2025 年,Mooncake 荣获存储顶会 FAST 最佳论文。

这是清华高性能所距离 2011 年首次发表 FAST 论文后,时隔 14 年的又一次重大荣誉。2011 年发表一篇 FAST 难如登天:FAST 2011 共收录 20 篇论文,其中 18 篇来自美国和加拿大,1 篇为美韩合作,仅有 1 篇由大陆学者独立完成,即郑纬民与张广艳的 FastScale 论文。14 年后,FAST 将最佳论文颁给 Mooncake,不仅体现了中国存储技术的科研话语权提升,还反映清华团队在推动传统存储持续创新上的敢为人先。

事实上,大模型从训练到推理的每一个关键步骤都离不开存储。

不止推理,大模型的训练也离不开存储。针对万卡集群系统在运行时可能出现故障,HPC 存储在过去已有解法,即在训练到 10 分钟时就知道一个小时要出错、然后主动停下来将当时的软硬件环境记到硬盘里,标记完后再继续训练。清华高性能所曾提出“分布式检查点”,将可能出错点的检查时间从数小时压缩到了十分钟内。

此外,在数据获取上,大模型研究要解决两个问题:一是系统能够高效可靠地存储高达上百亿个文件的数据,二是能找到文件存储的位置并尽快读取。获取的数据要进行预处理,处理后的数据质量会直接影响模型的性能。存储领域的“分布式文件系统”技术就是专门解决这类问题。

陈康是清华高性能所在分布式文件系统上的开拓者。

陈康(左)、张广艳(右)

从 2015 年开始,陈康与当时刚刚入学读研的闪英迪(现任清华大学计算机系助理研究员)合作,围绕分布式文件系统展开了一系列研究。当时的分布式文件系统在出现数据损坏时,往往需要数小时甚至数天来完成故障修复,而冗长的修复过程又极易造成数据的二次损坏乃至永久性丢失。

为了解决这一难题,陈康与闪英迪从信息论领域挖掘出一种名为再生码的信息编码,并创新性地将其应用于分布式文件系统。他们设计了与再生码相适应的硬盘数据结构,使系统的数据修复时间降低至分钟级。

随后,伴随固态硬盘与 RDMA 网卡的逐步普及,他们发现先前的分布式文件系统架构已经无法充分利用新型硬件的性能,又带领团队里的硕士生王润基等人共同设计并实现了新一代分布式文件系统 MadFS,并成功部署在鹏城云脑 II 智算平台上。MadFS 一举夺得 2021 年 IO500(全球超算存储 500 强)榜单冠军,是国内科研机构在该榜单上首次登顶。

2023年起,IO500 冠军由舒继武和陆游游团队开发的文件系统 SuperFS 夺得。

陆游游是国内闪存与分布式内存方向的先驱青年科学家。在闪存SSD、内存与网络等高速硬件构成的现代数据中心里,发挥高速硬件的性能是新型存储系统设计的重要挑战。基于闪存与内存系统的研究积累与实践经验,陆游游带领曾少勋、郭昊、杨倚天等学生设计开发了全新的文件系统SuperFS,数据带宽达到硬件理论带宽的 90% 以上,元数据性能刷新世界纪录,在相同硬件条件下系统效率提升约 9 倍。

目前,陆游游也在研究大模型训练与推理的存储系统,从向量存储、参数存储切入探索下一代大模型记忆存储基础设施。

陆游游

陆游游 2009 年从南京大学本科毕业后到清华高性能所读博,师从舒继武,博士期间在裸闪存上取得了十分突出的成绩——国际首次提出 Open_channel 闪存存储,在 FAST、SOSP 与 OSDI 等顶会上发表了中国第一篇闪存论文,2016 年开始在 Linux 社区被广泛推广。也因此,陆游游博士后一出站即拿到了清华的教职,留校任教。

2013 年之后,陆游游转向分布式内存研究,2017 年提出了基于 RDMA 的分布式共享内存池 Octopus——这是国际上第一个结合非易失内存和 RDMA 的分布式文件系统,其性能在独立评测中远超其他文件系统。这项研究得到了国际同行的广泛关注,被多位国际知名学者在国际学术会议的 keynote 报告介绍,被 Intel、Mellnox 等多个工业巨头在国际组织的报告中讨论,也在多个大学的课堂教学中研讨。

2022 年,陆游游团队又发表了分离式内存成果 Sherman(下一代数据中心内存底座),Sherman 后来获得数据库顶会 SIGMOD 2023 的“研究亮点奖”(Research Highlight Award),是大陆团队首次获奖。这项工作也在2025年再次入选 ACM 通讯(Communications of ACM)研究亮点成果。

从 2010 年到 2020 年,陆游游与团队主要关注闪存与内存,也在研究过程中发现了存储在 AI 系统中的重要性。2019 年开始,陆游游与团队开始探索推荐系统中内存和 GPU 显存的管理,与快手合作在真实系统中取得了显著收益。到大模型时代,GPU 显存与传统存储层次之间的协同问题表现突出,因为大模型距离 GPU 内部的计算单元越来越近,不再仅仅是 SSD 或内存的性能,可能还要去关注 HBM 与互联的性能。

今年,陆游游团队基于过往文件系统研究大模型的存储,在亚马逊支持的 ASPLOS/EuroSys 2025 大模型推理优化竞赛中获得了第一名。

五、计算永不过时

尽管当前清华高性能计算团队对大模型的 Infra 支持与探索是从传统 HPC 技术出发,但他们的布局并不止于此。除了传统 HPC 的创新,同时他们也永远在探索 HPC 之外的下一代更快、更好的计算范式,如张悠慧在研究的类脑计算。

张悠慧

不同于 HPC,国内的类脑计算发展基本和海外同步。

张悠慧 1993 年考上清华计算机系,本科第五年就进入计算机系统及应用教研组,先是跟着汪东升做研究,后师从郑纬民读博,参与了集群系统的研究。2002 年博士毕业后,张悠慧留校任教,先在汪东升组研究处理器,参加了当年由国务院“18号文”(2000 年 6 月 24 日印发)催热的首波“中国芯”热潮。

由汪东升、鞠大鹏、张悠慧等人组成的小组于 2004 年成功研制了当时国内主频最高的 “清华芯”(代号 THUMP 107),并与国内头部厂商开展了体系结构定制设计方面的长期合作,但高端突破仍待时日。2014 年,在施路平的影响下,张悠慧就转向了类脑计算。

当时人工智能刚起来,类脑神经网络被称为“第三代人工智能网络”,非常超前。张悠慧转变方向后,主要研究类脑芯片的设计与类脑编程范式,用了不少高性能计算机体系结构的设计方法论——这也使得后来他在类脑计算的研究中一直强调要保持系统的软硬件去耦合特性以及系统的“通用性”。

从信息社会的发展来看,整个计算机体系结构到目前最成功的仍是通用处理器架构,即冯诺依曼架构,原因是图灵完备性从理论层面解决了根本的问题:一个图灵完备的语言写出的程序,肯定能够等价转化为图灵完备系统上的一个等价程序,而冯诺依曼架构是实现图灵完备的一种最常见、最实用的工程方案。

张悠慧在类脑研究中也采用了通用计算机的方法论。比如在 2020 年与施路平合作发表的国内计算机系统领域的首篇 Nature 论文,就被当期的 Nature 评论文章认为,所提出的类脑计算完备性之于类脑计算系统,就如同图灵完备性之于通用计算机。

高性能计算会分为软件、硬件、编译等不同层次,且不同层次之间能够独立演化,张悠慧也深受启发,诞生了研究类脑通用编译器的想法,将类脑应用程序分层转换为芯片上的可执行程序,层间去耦合、转换可复用。这样做的原因在于——

目前的类脑系统生态存在软件碎片化的问题,往往要围绕不同的类脑芯片开发与之适配的中间软件和应用。即每一个都是分割的纵向绑定,开发出来的中间层次和应用都是针对特定的芯片,换一个芯片就要重新开发。这就导致整个类脑研究社区难以共同演进。

但是研究通用处理器的人,从来不会去担心这个处理器上能不能跑一般的应用,写应用的人也从来不会考虑在这个处理器上能不能跑——肯定能跑,因为通用计算机是图灵完备的,且从应用到处理器硬件横向分层,中间编译器已经做了很多事情,使得底下的硬件特质早就被屏蔽掉,所以软件和硬件可以独立发展、彼此不被束缚。

针对这个问题,张悠慧与郑纬民、施路平、高光荣一起讨论过很多次,最后在 2019 年决定从类脑计算系统的层次结构入手,借鉴图灵完备性与冯诺依曼架构体系,提出了类脑计算完备性。这个工作从构思到成型大概 9 个多月,赶在疫情前夕完成,最后登上 Nature。

张悠慧从 2014 年开始研究类脑计算,一共发表了两篇 Nature,第一篇是与施路平团队合作的天机二代。天机二代芯片做了 DNN 与 SNN 的异构融合,支持两类芯片、两类网络的同时运行,登上 Nature 封面,施路平主导、张悠慧为共同一作,是国内类脑芯片的开山之作。

从 2014 年到 2021 年,张悠慧参与过两代天机芯片的研发,主导了天机一代与二代的工具链研发,解决了网络部署的问题。从论文公开情况来看,施路平、裴京、张悠慧以及其他合作者共同发表在 IEDM 上的论文是国内第一篇类脑计算芯片论文。

2021 年后,张悠慧逐步开始设计通用计算与类脑计算融合的新型芯片。在芯片设计上,张悠慧也是从计算机系统结构的思路出发,用“通用的微体系结构扩展”,进行通用处理器的类脑计算定制化设计。这样可以取得两方面效果:一是容易编程,易用;二是体系结构优化到一定程度就能实现编程灵活性和性能的兼备。

比如拿 RISC-V 去扩展,用指令集或较通用的微架构扩展来支持类脑神经网络的快速运行。这样的好处是,软件能够灵活编程来支持各类类脑应用,而不需要重新去开发一个新芯片;而且运行性能要显著高于某类采用定制电路方式的 SNN 加速器芯片。

张悠慧提出的类脑计算系统层次结构,解决了类脑芯片与应用紧耦合问题。后来,课题组的助理研究员渠鹏(2009年河北省高考理科状元)将这一解耦合方法论迁移至信创领域,在信创产业亟需解决软件跨平台适配迁移的背景下,创新性地将大模型技术与编译技术结合,提出基于 “统一中间表示” 的跨平台软件适配迁移技术。

该技术利用大模型的代码理解与生成能力,实现对非跨平台代码段的智能化定位与跨平台转换, 并通过编译技术辅助实现准确性提升,从而显著降低了信创软件的移植成本。2023年,这项技术与浙江金网合作,孵化了国内首款信创适配一体机产品。

目前张悠慧在类脑计算的研究主要有两块:一是开发跨平台的编译器,希望在写程序的时候不必有太多硬件上的约束,而且支持新的类脑芯片时可以尽量避免重复造轮子;另一块就是用通用处理器做类脑计算扩展。

GPU 擅长密集计算和规则计算,但是对具有大量不规则访存、稀疏计算特征的诸如神经动力学仿真应用,效率非常低。张悠慧将类脑与通用计算结合所设计的芯片对这类应用体现出了出色的加速作用,同时能保证高计算精度。

张悠慧转向类脑计算,汪东升则将研究重点从国产芯片转向了处理器的硬件安全上。

汪东升

现代处理器朝着高性能、低功耗和智能化的方向发展,硬件的安全问题也不容忽视,2018 年 1 月爆出的“熔断”和“幽灵”漏洞就是出现在处理器的高性能处理模块,同年汪东升团队发现的“骑士(VoltJokey)”漏洞则隐藏在普遍使用的低功耗动态电源管理单元。通过“骑士”漏洞,黑客无需借助任何外部程序或者链接就可以直接获取用户的安全密钥,影响了全球大量计算设备、且设计到处理器芯片的核心架构。

对此,汪东升团队从信息论、数学和测试等角度提出基于熵变、形式化验证和多层次覆盖率模型的硬件漏洞检测与挖掘方法,在架构层面设计了大规模分布式硬件漏洞智能挖掘与安全检测平台,可对硬件进行批量化、自动化和智能化漏洞挖掘与安全测评。

他们相继发现了通用处理器的“幻影”、“超车”、瞬态执行计时侧通道、PMU 侧通道以及 GPU的“闪电”等漏洞,对处理器领域预先安全防御作出了巨大贡献。

六、技术的英雄主义

大模型时代,HPC 的机遇加大,挑战与压力也倍增。

在过去,系统软件的研究一般只需与芯片厂商合作,如今也必须与模型厂商合作——因为在大模型的性能优化上,光做软件优化也许只能将 token 输出从每秒 10 个提升到 50 个,若要提升至每秒 500 个 Token 的输出则必须与算法人员一起从底层算子、Transformer 架构、算法公式等改起。

章明星认为,未来软硬协同设计的趋势会更加明显,接下来大模型在软硬协同上会有两个趋势:一是稀疏大模型的发展会加大对算力侧的需求,二是提高强化学习驱动的模型推理性能。现在章明星也在应用 Mooncake 作强化学习的训练优化。

理论上,模型层可以往下探究、芯片层也可以往上延伸,所以位于中间层的 HPC 软件创新天然受到底层芯片与上层模型的“两头挤压”。不过,在承压中作性能的极致创新几乎已是 HPC 的天性,且随着大模型的竞争愈发激烈,国产芯片崛起,软件创新的重要性仍在提高。

大规模集群的国产化成必然趋势。DeepSeek 在算法层面打破了 OpenAI 对中国的垄断和领先,但底层算力上中美仍有较大差距。中美 AGI 之间的竞争,与其说是模型之间的竞争,不如说是 AI Infra 之间的竞争。DeepSeek 出圈后,陈文光就产生了一个想法:

下一个中美科技战的里程碑,应该是用国产的芯片训练出国际一流的高水平大模型。

翟季冬成立清程极智,为大规模集群开发系统优化软件,主要做两件事:

一是并行处理——用一张卡跑大模型训练是“串行”,100 张卡则要做“并行”,理想情况是 100 张卡的训练速度能比一张卡快 100 倍,但囿于卡与卡之间的通信等原因几乎不可能。一般的团队只能实现二三十倍,他们希望做到快七八十倍、甚至九十倍。

二则是编译软件开发——将上层的大模型编译到国产卡中。好的编译软件能大幅提升芯片的计算性能、节省硬件投入。大模型的训练集群硬件投入成本往往超十亿元,优化后即使节省 1/3 乃至 1/4 的成本也是一笔大数目。

翟季冬很早就决定,除了英伟达,也要深度支持华为、沐曦、海光、燧原、寒武纪等十几家国产芯片。

一方面,美国对中国市场禁售后,拿到最新的芯片难度更高,比如英伟达的 GB200 NVL72 就是一个超节点,如果能获得就可以开展更多推理的优化,否则就要关注国产卡;但另一方面,国产芯片也面临软件生态不完善的挑战,导致大模型在国产卡上跑起来需要开发更多软件。

国内目前专注 AI 系统编译的团队不多,现任清华高性能所助理研究员的王豪杰是其中之一。

王豪杰硕士师从陈文光,博士受翟季冬指导,2021 年博士毕业后开始从纯编译转向 AI 系统研究,主要关注国产芯片生态——英伟达芯片禁售后,如何通过编译在国产卡上将中间的答案写得像在英伟达上一样好,是一个突出的挑战。

王豪杰

从编译角度看,每换一款新的芯片,涉及到的底层基础建设和编程接口都会有差异,所以如果决定支持一款新的芯片,软件架构上的调整要使上层所有优化不因新的芯片而崩溃。而在国产卡上,大量原先能在英伟达上跑的编程接口都无法使用,这就需要在工程实现上做大量的工作。

“针对每款芯片都写一个系统肯定不现实,理想情况是将 10 款芯片统一起来做通用优化。”王豪杰解释。系统越通用,性能优化空间就会越小。底层芯片的集合带出了一个新的编程范式,也带来更大的挑战。

这个过程中有许多因素是他们所无法控制。以大规模集群国产化替代为例,底层工艺水平与上层生态环境的挑战是芯片厂商也要花时间弥平的差距。

以英伟达为例。所有的新技术推出后都先适配英伟达的 H100,即使 DeepSeek 开源的许多技术也是基于 H800、A800 展开,将相关内容迁移到国产芯片上至少需要数月的时间。但好在,HPC 的研究也往往以 2、3 年为一个时间单位,耐心与完美主义几乎是从事这行必备的两个要求。

“因为到最后大家拼的都是剩余的 5%-10% 空间优化。”

相比算法,系统是一个更冷门、也更需要个人具备技术英雄主义情怀的领域——系统软件的编写要求超强的代码能力,有时甚至需要涉及古早的汇编语言,系统人才兼备十八般武艺、其中大多还都是计算机系的学生最敬而远之的几门学科。

比如清华高性能所去 DeepSeek 的两位学生中,一位曾单枪匹马写了 MadFS 中的大部分代码、并曾用 Rust 语言迅速复现谷歌基于 Dart 语言开发的操作系统 Fushisia,还有一位在国内某大厂训练大模型时一个人战斗力顶七个人。

值得注意的是,到目前为止,国内许多高校在设立学科时依然没有成立系统方向。

2005 年,清华信息国家实验室成立了清华高性能计算公共服务平台,作为清华基础科研条件建设的重要内容。高性能所承担了主要的平台建设工作,张武生、林皎是两大主力,张武生负责平台的系统级研发工作,林皎负责平台的技术支持和用户服务。

其中,张武生开发了一套可支持通用和国产自主可控算力平台的可定制集群操作系统和操作系统沙箱服务一体机,重点应对 AI 算力平台的异构性、动态变化、负荷大等特征带来的挑战。

林皎从“稳定的系统环境+丰富的软件资源+优质的技术服务”对平台进行管理,研发了“集群自动检测与修复系统“、”集群节能系统”等成果,并完善系统环境、培养 HPC 应用人才,使平台高效运营。

2005 年至今,清华高性能计算平台建设了“探索3号”、“探索100”、“探索200”、“探索1000”几代超级计算系统,向校内外 46 个院系单位、312 个课题组提供高性能计算服务,用户发表 SCI 论文1231篇(其中 CNS 论文 51 篇)。

2024年,平台完成了“开拓1000”智算系统建设,有力推动了清华人工智能及其相关学科领域的发展。

由于技术与人才培养的杰出贡献,清华高性能所多次获得集体荣誉,尤其是在前任支部书记赵颖的带领下获评全国党建工作样板支部,是清华大学第一个成功创建国家级样板的教师党支部。

智能基础软件栈的目标是整合高性能所以及典型开源的成果,方便包括大模型在内的智能计算业务的开展,目前已取得初步成果:开发出了九源智能基础软件栈,并完成了与国产基础硬件(飞腾、鲲鹏处理器以及昇腾、寒武纪、昆仑芯等加速芯片)和软件(麒麟、欧拉等操作系统)的适配。

除了构建底层统一智能计算架构、使同一程序运行在多个硬件上成为可能,九源智能基础软件栈还提供了面向模型智能的高效训推平台和智能编译优化系统,面向数据智能的大数据智能分析系统、高性能缓存存储系统、分布式图数据库,不仅能可以满足模型的训推需求、支撑检索增强生成(RAG)等大模型应用场景。

这个方向已是万丈高楼,但只要计算机存在,只要芯片、应用仍不断发展,人们就要解决一个问题,就是如何让代码在计算机上跑得更快,高性能计算技术就能被派上用场。所以,这注定是一条求新的漫漫长路,需要一个人独行,也需要一群人并肩。

也以此文致敬金兰、郑衍衡、王鼎兴、沈美明、苏伯珙、谢树煜、汤志忠和温冬婵等教授。

应用没有终点,计算也没有终点。

(朱可轩、洪雨欣对本文亦有贡献)

不确定的时代更需要乐观的技术理想主义者,更多大模型、AI、具身智能的精彩故事,欢迎添加作者微信 Fiona190913 交流。