Hello folks,我是 Luga,今天我们来聊一下人工智能应用场景 - 构建大模型应用架构设施底座:异构算力。

在后摩尔时代与AI爆发的双重驱动下,计算架构正经历一场从同构到异构的深刻变革。

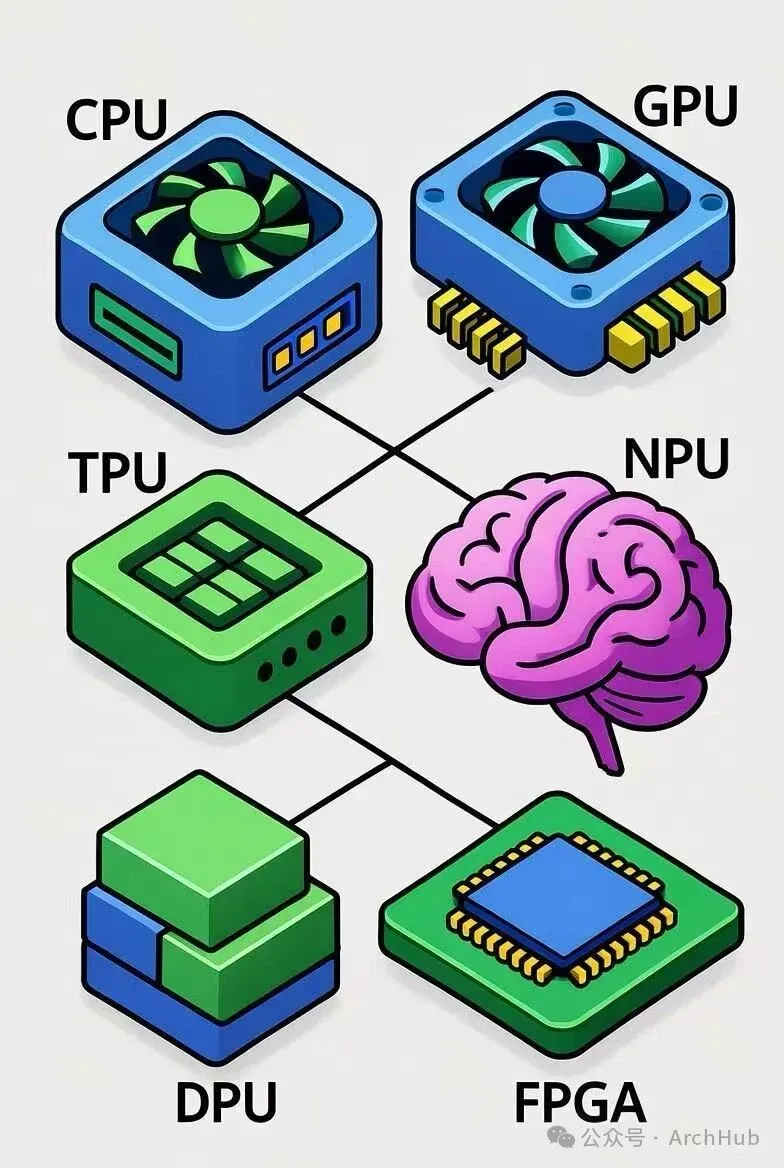

以 GPU、NPU、FPGA、DPU 等加速器为代表的异构算力已成为提升系统性能和能效比的关键。然而,如何对这些特性迥异的算力资源进行高效、公平、稳定且智能的调度,已成为横亘在云计算、高性能计算、边缘计算乃至通用计算领域的一大“卡脖子”难题。

本文将从宏观架构、微观机制、业务场景三个维度,深入剖析高效异构算力调度面临的挑战,并探讨其本质、根源与潜在的解决之道。

一、如何看待:从“算力红利”到“算力瓶颈” ?

在过去十年中,算力被视为 AI 发展的燃料。从 CPU 到 GPU,从 TPU 到 NPU,计算架构的演进速度前所未有。然而,当算力类型变得越来越多样、越来越分散时,一个被忽视多年的问题开始浮出水面:

算力的调度效率已经成为系统整体性能的瓶颈。

换句话说,我们拥有越来越多的“引擎”,但缺乏一个足够聪明的“驾驶员”以便“驾驭”……

例如,在一个典型的 AI 计算平台中,可能同时存在多种硬件:用于通用任务的 CPU、用于深度学习的 GPU、用于矩阵运算的 TPU 以及用于视频编解码的 ASIC 芯片,同时,还有可能一些用于低功耗推理的 NPU。

上述算力资源在架构层面完全不同,在编程接口上各自为政。系统如何让这些算力协同起来?如何让每个任务在最合适的硬件上执行?这正是“异构算力调度”的核心问题。

而“高效”二字,更意味着:在性能、能耗、成本、任务时延、资源利用率之间取得动态平衡。这不是简单的任务分配,而是一场系统级的平衡艺术。

二、架构范式本质:从“资源池化”到“算力编排”

从架构视角看,异构算力调度的挑战首先来自于资源的非对称性。即宏观架构挑战:异构性带来的复杂资源管理

1. 资源描述与抽象的异构鸿沟

众所周知,不同的异构设备拥有完全不同的计算模型、内存结构、I/O 特性和编程接口。传统的资源抽象(如 CPU 核数、内存大小)难以适用。因此,异构算力调度难的第一层原因,是底层硬件生态的割裂。

在当下的计算环境中,几乎每一种硬件都绑定着独立的编程模型与驱动体系,具体可参考如下:

- NVIDIA GPU 之 CUDA;

- AMD GPU 之 ROCm;

- 华为昇腾 NPU 之 CANN;

- 寒武纪 MLU 之 Cambricon SDK;

- FPGA 之 Vitis 以及 OpenCL 等编译框架。

调度系统如果要统一管理这些设备,就必须理解这些底层栈的运行机制。而问题在于,这些体系几乎没有统一标准。

例如,在一个混合训练集群中,调度器需要判断:某个深度学习任务是否能在 NVIDIA GPU 与华为 NPU 之间迁移?迁移的代价是多少?显存不兼容如何处理?

然而问题是:目前几乎所有开源系统(包括 Kubernetes、Slurm、Ray)都无法直接回答这个问题。这就像一家公司拥有来自世界各地的工程师,每个人只讲自己的母语,没有统一的技术文档。管理难度可想而知。

我们以某 AI 公司云平台中的调度场景为例,此公司自研 AI 云平台,底层同时部署了 NVIDIA GPU、昇腾 NPU、FPGA 加速卡。由于驱动栈不同,调度器无法统一识别硬件状态,导致部分任务只能“手工绑定”节点。即便硬件空闲,任务也可能等待数小时,集群利用率长期低于40%。

2. 动态负载与工作负载的算法实现难题

调度器本身的“智力”仍停留在静态规则时代。异构设备适用于特定的工作负载。将错误的工作负载调度到错误的设备上,会导致资源浪费和低效。

目前主流的调度系统(如 Kubernetes Scheduler 或 Slurm)大多基于预定义规则:资源匹配、优先级、亲和性、反亲和性等。这些规则在同构环境下尚可奏效,但在异构场景中却显得笨拙。

例如,一个 AI 训练任务可能包含两阶段:数据预处理(CPU密集)与模型训练(GPU密集)。若调度器只看到资源维度,而忽略任务阶段特征,就可能把整个任务绑定在 GPU 节点上,导致 CPU 空转、GPU 等待。

更复杂的场景便是混合工作负载,即同一集群中同时存在批处理任务、在线推理、图像渲染等业务。每类业务对时延、能耗、带宽的敏感度不同,调度器若无法动态调整策略,就会导致整体性能下降。

我们以视频云平台的“资源挤兑”问题为例,在多任务并发渲染时,调度系统采用静态分配策略,优先分配 GPU 给大型任务。结果导致短时任务排队过长、延迟飙升。后来引入基于强化学习的动态调度模型,通过实时监测任务执行特征,自动调整优先级,整体 GPU 利用率提升 25%,任务平均完成时间下降 30%。

3. 虚拟化与共享的复杂性

为了提高利用率,有的时候,我们需要基于特定的业务诉求进行必须支持多租户共享异构资源,但问题是:异构设备的虚拟化难度远高于CPU。

针对 GPU 虚拟化:

- 全虚拟化(vGPU): 性能开销大,但隔离性好;

- 而直通(Pass-through)模式: 性能好,但无法共享;

- 而细粒度共享(MIG/SR-IOV)技术: 则提高了共享粒度,但增加了调度器对物理资源的细致管理难度。

例如,在 Kubernetes 集群中,如何确保一个算力 Pod 只使用分配给它的 GPU 显存和计算资源,而不影响同一物理 GPU 上的其他 Pod ?这要求调度器不仅与 Kubelet 交互,还需要与底层的设备驱动和 Runtime(如 NVIDIA Container Toolkit)深度集成,实施显存超卖管理和计算抢占/隔离策略。

4. 软硬件协同的接口鸿沟

异构算力调度不仅是软件问题,更是软硬件协同的系统工程。目前调度层与硬件驱动层之间缺乏统一接口。调度器虽然知道“某节点有 4 块 GPU ”,但并不了解这些 GPU 的运行温度、显存占用、PCIe 带宽或是否启用 MIG 分区。

这种信息鸿沟使得调度决策无法做到细粒度。例如,在大模型推理中,显存是关键瓶颈。如果调度器不了解每张 GPU 的显存可用量,就可能将任务调度到“显存不足”的设备上,导致任务频繁失败或被迫回退。

例如,以 AI 推理集群中的显存争夺案例为例,在一家 AI SaaS 企业中,多个模型共享同一 GPU 池。

由于调度器只能基于“ GPU 个数”调度,无法识别显存分配状态,经常出现显存冲突。后来通过引入基于 MIG(Multi-Instance GPU)的细粒度虚拟化机制,并在调度层增加显存感知逻辑,任务失败率下降 90%。

5. 资源利用率与能效的平衡

算力调度不仅追求“任务跑得快”,更要在性能与能耗之间取得平衡。

在大规模 AI 集群中,GPU 常常成为能耗主力。以一个拥有 1000 块 A100 的集群为例,峰值功耗可达 1.5 MW,单日电费超过10万元。如果调度策略无法合理分配任务,导致 GPU 长期低负载运行,这不仅浪费资源,更直接增加运营成本。

在企业实践中,越来越多的架构师开始关注“能效比”指标,即每瓦特算力所能完成的任务量。

以智慧城市推理节点的能效调度场景为例,在某城市级AI监控系统,边缘节点部署了 NPU 与 GPU 混合架构。

传统策略按固定比例分配任务,结果在夜间监控量下降时,GPU 仍保持高功耗待机。后续改造后,系统能根据负载自动将任务迁移到低功耗 NPU,GPU 进入休眠模式,整体能耗降低近 40%。

三、异构算力调度的本质与未来方向

当前,异构算力调度已超越传统的资源分配逻辑,演进为一个复杂的系统级价值优化问题。其核心挑战在于,如何在高度异质化、分布化的物理硬件之上,构建一个能感知业务意图、并能动态协调时空拓扑的智能调度层。这要求我们从底层架构范式、跨域协同机制与行业生态标准三个维度进行根本性重构,以将原始的“算力”高效地转化为“生产力”。

1. 架构内核:从均质分时到异构意图的调度范式迁移

传统 CPU 调度建立在“资源同构”与“进程对等”的假设之上,其核心是通过时间分片在均质资源上模拟公平性。而在异构架构中,这一范式彻底失效。调度器的核心职责不再是公平地分配“时间”,而是精准地匹配“计算意图与硬件能力在时空维度上的拓扑关系”。

调度目标出现根本性转变,从追求单一线程的低延迟,转向最大化整个异构集群在单位时间内的任务吞吐量 或价值完成度。一个任务的价值,取决于其所需的各种异构资源(如 GPU、DPU、FPGA)能否被高效、协同地供给。

2. 架构演进:解耦、卸载与联邦调度构成的下一代算力平面

为应对上述挑战,基础设施架构正沿着“解耦”与“联邦”两个方向演进,这直接重塑了调度器的设计边界。具体体现在如下2点:

(1) 深度解耦与智能卸载:DPU/IPU的兴起,标志着控制平面与数据平面的物理分离。网络、存储与安全功能被从主机CPU卸载,形成了独立的“基础设施域”。这使得调度决策必须从单一的“计算负载”视角,升级为计算、I/O与存储的协同视角。

(2) 联邦调度:构建逻辑统一的跨域算力池:边缘、数据中心与混合云构成了物理上分散的“算力孤岛”。联邦调度器的架构价值在于,在物理分散的前提下,抽象出一个逻辑统一的全局资源视图。它不直接管理底层所有资源,而是通过一套标准协议进行跨域协商与委托调度。

3. 架构基石:通过标准化接口构建可持续演进的生态

长期来看,解决异构复杂度必须通过标准化来降低系统熵增。这关乎整个软硬件生态的构建。具体体现在如下:

(1) 硬件抽象层标准化:OAM等硬件标准试图在物理形态、供电散热与高速互连上形成规范,为不同厂商的加速器建立“可互换”的物理基础。这是硬件层面的“解耦”。

(2) 软件接口统一化:在软件层面,需要将CRI/OCI等容器运行时接口向异构设备扩展,实现加速器资源的声明式发现与分配。这要求设备插件模型从简单的“数量上报”进化到能描述设备能力、拓扑关系与健康状态的“资源画像”。

(3) 生态集成深度:最终,所有标准与接口的价值,体现在与主流调度框架(如Kubernetes)的深度融合上。通过开发更高级的运算符或自定义资源,将异构资源的调度逻辑从“应用如何适配基础设施”的反模式,转变为“基础设施如何满足应用意图”的正交模式,从而实现架构的长期可演进性。

因此,综上所述,高效的异构算力调度是计算架构演进中的一个关键里程碑,要求我们从简单的资源计数转向复杂的拓扑、通信和工作负载匹配。这不仅仅是一个算法优化问题,更是一个需要系统性变革的架构设计问题。

未来的调度系统应该具备如下特性:

- 拓扑感知的: 能够理解并利用硬件互联优势。

- 智能化/预测性的: 能够利用数据预测负载并做出前瞻性决策。

- 分层解耦的: 实现资源管理与业务逻辑的清晰分离

- 可编程的: 允许用户和管理员定义灵活的调度策略。

只有构建出这样的新一代调度架构,才能真正释放异构算力的巨大潜能,支撑起未来 AI 和大规模计算的需求。

今天的解析就到这里,欲了解更多关于 “大模型技术”相关技术的深入剖析,最佳实践以及相关技术前沿,敬请关注我们的微信公众号或视频号:架构驿站(ArchHub),获取更多独家技术洞察!

Happy Coding ~

Reference :

[1] https://developer.nvidia.com/

[2] Dynamic GPU Fractions(动态 GPU 分配),知多少?

Adiós !