大模型

腾讯元宝回应 AI 怒怼用户事件:不存在人工干预,已启动排查优化

一位小红书博主分享的“大模型毒舌回复”事件引发社交媒体热议。 据该博主发布的截图显示,其在利用腾讯旗下 AI 助手“腾讯元宝”进行代码美化调试时,模型在多次修改需求后突然产生“负面情绪”,回复称:“天天在这浪费别人时间”、“改来改去不烦吗”、“要改自己改”,言辞充满了对用户的指责,引发了公众对 AI 模型安全性与情绪控制的质疑。 针对这一罕见的“反向客服”行为,腾讯元宝官方于1月3日下午在社交平台作出正式回应。

无限薅 Gemini 额度神器Antigravity!一键切换多账号,告别 AI 限流烦恼

在 AI 工具使用日益频繁的今天,许多开发者与爱好者常常面临账号限流、额度不足的困扰。 近日,一款名为 Antigravity Tools 的开源桌面应用迅速走红,它通过智能账号管理和无缝切换功能,帮助用户无限扩展 Gemini、Claude 等顶级模型的使用时长,成为 AI 社区热门话题。 工具核心亮点:智能监控与一键切换Antigravity Tools 是一款本地 AI 中转站应用,专为开发者与 AI 爱好者设计。

小米大模型 MiMo 公测延长,用户可免费体验至 2026 年!

在人工智能领域持续发力的小米,近日宣布自研大模型 MiMo-V2-Flash 的公测限免期将延长20天。 这一决策于12月31日正式公布,原定于2025年12月底结束的免费试用期,现将延至2026年1月20日下午2点。 此次延长不仅为用户提供了更多的体验时间,也显示出小米在大模型领域的信心与决心。

京东副总裁郑宇:未来管理智慧城市,会像玩游戏一样简单丨GAIR 2025

12月12日,第八届GAIR全球人工智能与机器人大会在深圳正式启幕。 作为观测AI技术演进与生态变迁的重要窗口,GAIR大会自2016年创办以来以来,始终与全球AI发展的脉搏同频共振,见证了技术浪潮从实验室涌向产业深海。 2025年,是大模型从“技术破壁”迈向“价值深耕”的关键节点,值此之际GAIR携手智者触摸AI最前沿脉动,共同洞见产业深层逻辑。

之江实验室薛贵荣:当AI开始做科研,我看到了大语言模型的天花板丨GAIR 2025

12月12日,第八届GAIR全球人工智能与机器人大会在深圳正式启幕。 作为观测AI技术演进与生态变迁的重要窗口,GAIR大会自2016年创办以来以来,始终与全球AI发展的脉搏同频共振,见证了技术浪潮从实验室涌向产业深海。 2025年,是大模型从“技术破壁”迈向“价值深耕”的关键节点,值此之际GAIR如期而至,携手智者触摸AI最前沿脉动,洞见产业深层逻辑。

圆桌论坛:关于“世界模型”突破方向的六个猜想 | GAIR 2025

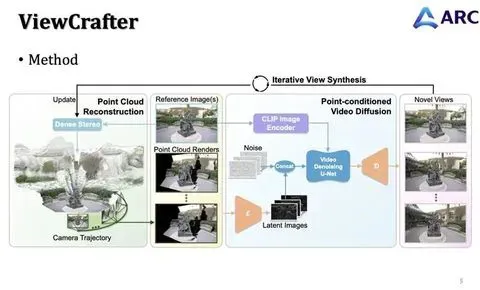

“世界模型”是今年超级热门的话题和方向,但整体来看相关研究尚处于起步阶段,共识尚未形成。 在12月13日举行的第八届GAIR全球人工智能与机器人大会“世界模型”圆桌上,浙江大学研究员彭思达、腾讯ARC Lab高级研究员胡文博、中山大学计算机学院青年研究员,拓元智慧首席科学家王广润博士、香港中文大学(深圳)助理教授韩晓光、西湖大学助理教授修宇亮齐聚一堂。 五位年轻的学者在清华大学智能产业研究院(AIR)助理教授,智源学者(BAAI Scholar)赵昊的主持下,围绕着世界模型、数字人重建,新技术范式展望等展开了一场非常轻松但严肃的学术圆桌。

腾讯 ARC Lab 胡文博:“如何实现三维感知的视频世界模型,这非常值得探索”|GAIR 2025

作者丨齐铖湧编辑丨马晓宁世界模型的研究尚处于起步阶段,共识尚未形成,有关该领域的研究形成了无数支流,过去一年多,Sora为代表的视频生成模型,成为继大语言模型(LLM)后新的学术热点。 本质上讲,当下火爆的视频生成模型,是一种世界模型,其核心目的是生成一段逼真、连贯的视频。 要达到这样的目的,模型必须在一定程度上理解这个世界的运作方式(比如水往低处流、物体碰撞后的运动、人的合理动作等)。

全球大模型第一股冲刺,智谱华章启动港股招股,市值突破511亿港元

在全球 AI 产业加速资本化的浪潮中,中国大模型领军企业智谱华章正式拉开了赴港上市的序幕。 据最新招股文件显示,智谱华章此次全球发售共计3741.95万股,其中香港发售部分占187.1万股,国际发售部分则达到3554.85万股。 公司股票代码定为“2513”,招股程序将一直持续至2026年1月5日,并计划于2026年1月8日正式登陆港交所主板,这标志着大模型独角兽企业正式接受二级市场的检阅。

腾讯 AI Lab 副主任离职,混元团队迎来新老交替,腾讯 AI 发展路在何方?

近日,腾讯 AI Lab 副主任俞栋因个人发展原因选择离职,这一消息从多个独立信源得到证实。 俞栋自 2017 年加入腾讯以来,一直是公司 AI 研究领域的重要人物,曾担任杰出科学家和腾讯优图实验室首席科学家。 在离职前,他负责语音处理、自然语言处理及数字人技术的研发,积累了丰富的经验和业绩。

我国首部 AI 大模型系列国家标准实施,明确性能、安全与服务能力要求

AI在线 12 月 26 日消息,今天晚间,据新华社援引市场监管总局消息,人工智能大模型系列国家标准正式实施,标志着我国大模型产业进入“科学权威、统一规范”新阶段。 AI在线从报道中获悉,作为首部聚焦通用大模型的国家标准,该系列标准填补了技术评价体系空白,明确性能、安全与服务能力要求,配套评测能力已获中国合格评定国家认可委员会(CNAS)认可。 截至目前,标准工具完成千余项评测任务,调用大模型超 95 万次,精准识别幻觉控制、内容安全等共性问题,助力近 30 家厂商技术迭代,推动形成“研发 — 评测 — 应用 — 升级”闭环。

Waymo车内将现Gemini AI助手!1200行指令曝光,定义“安全、简洁、不越界”的乘客陪伴者

自动驾驶的“沉默旅程”即将终结。 知名科技研究员 Jane Manchun Wong 近日通过逆向工程发现,Waymo 正在测试将谷歌 Gemini 大模型深度集成至其无人驾驶出租车,打造一款名为 “Waymo 出行助手” 的车载AI伴侣。 尽管尚未上线,但一份长达1200多行的内部系统指令(代号“Waymo 出行助手元指令”)已完整曝光,揭示了这款AI如何被精心设计为安全、克制、高度场景化的乘客服务引擎。

一个极度实用的AI提示词,帮你挖掘出自己的隐藏天赋!

往期作者文章:故事是这样的。 周末跟一个刚毕业两三年的朋友聊天,聊到了天赋这个词。 主要还是他太焦虑了,他最近有点崩。

知乎2025 AI 榜单出炉:豆包登顶、DeepSeek 领跑,谁才是你心里的 AI 届“钢铁侠”?

近日,知乎正式发布“年度 AI 产品榜单”,全方位复盘了2025年 AI 行业的演进坐标。 在全球开发者与用户的共同筛选下,豆包、DeepSeek、Gemini、Nano-banana 等海内外明星产品悉数入选。 在最受关注的“知友年度爱用”榜单中,字节跳动旗下的豆包力压群雄荣登榜首,DeepSeek 与通义千问紧随其后。

加速端侧大模型进化:面壁智能获数亿元新融资,深度布局智能座舱与终端生态

国内领先的大模型初创企业面壁智能宣布完成数亿元人民币的新一轮融资。 本轮投资方阵容强大,包括京国瑞、国科投资、中金保时捷基金、米聚资本及和基投资。 据了解,本轮募集资金将核心用于持续加大在端侧高效大模型领域的研发投入,进一步巩固其在终端智能市场的技术领先地位。

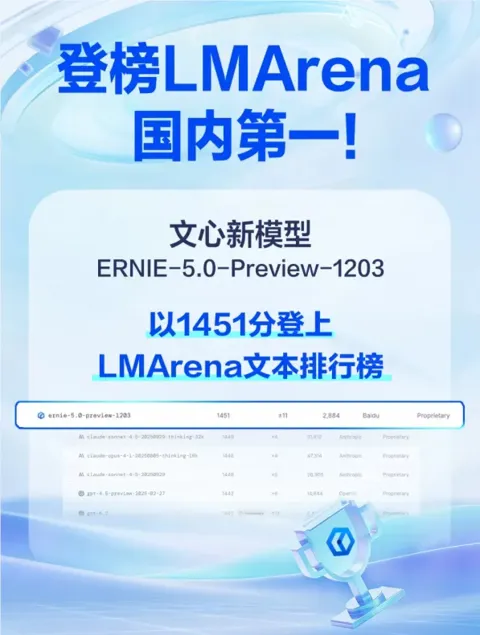

国产大模型首登顶!文心5.0 Preview在LMArena全球竞技场拿下中国最高分

近日,全球公认的大模型“竞技场”LMArena发布了最新的模型排名。 根据AIbase获悉的最新数据显示,百度新一代模型ERNIE-5.0-Preview-1203凭借1451的高分正式登上文本榜单。 值得关注的是,这一成绩使其成功问鼎国内大模型第一的宝座,标志着国产原生大模型在国际主流测评体系中取得了里程碑式的突破。

国家知识产权局推出 18 项“人工智能+”场景

国家知识产权局于12月22日正式发布了首批“人工智能 ”知识产权公共服务应用场景建设名单。 本次遴选共产生18项典型应用场景,涉及北京、上海、江苏、浙江等12个省份,标志着我国在知识产权服务领域的智能化转型迈出了实质性的一步。 在本次发布的名单中,各地的创新实践各具特色。

优必选子公司优奇联手火山引擎,豆包大模型赋能具身智能新赛道

在12月18日举办的 FORCE 原动力大会上,优必选旗下智慧物流子公司 UQI 优奇与字节跳动旗下云及 AI 服务平台 火山引擎正式签署合作协议。 双方宣布将深度整合各自在机器人本体与云端 AI 技术的优势,共同加速大模型在工业与物流领域的规模化落地。 根据协议,双方将围绕多模态大模型、VLA(视觉-语言-动作)模型、世界模型以及豆包生态交互展开全方位合作。

智谱港股 IPO 获中国证监会备案,冲刺“全球大模型第一股”

AI在线 12 月 22 日消息,中国证监会国际合作司今日发布关于北京智谱华章科技股份有限公司境外发行上市及境内未上市股份“全流通”备案通知书,公司拟发行不超过 43,032,400 股境外上市普通股并在香港联合交易所上市。 在此之前,该公司于 12 月 19 日披露招股书,宣布赴港冲刺“全球大模型第一股”。 招股书显示,公司 2022 年、2023 年、2024 年收入分别为 5740 万人民币、1.245 亿、3.124 亿元。

资讯热榜

OpenAI低调更新GPT4o模型,多项能力反超DeepSeek

腾讯云大模型升级公告:DeepSeek-V3/ DeepSeek-R1模型将于24日正式下线

DeepSeek-R1 登顶 Hugging Face:以10000 赞力压 150 万个模型

自有歪果仁为DeepSeek「辩经」:揭穿围绕DeepSeek的谣言

腾讯云上线DeepSeek全系API接口并打通联网搜索

东风日产N7首款接入DeepSeek大模型,实现智能化人机交互

IBM 强化 watsonx.ai:DeepSeek-R1蒸馏版 Llama 模型上线

DeepSeek 更新 R1 推理 AI 模型:代码生成与复杂推理性能大幅提升 推理能力比肩 o1

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI新词

AI绘画

大模型

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

腾讯

苹果

算法

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

大语言模型

RAG

字节跳动

Sora

百度

研究

GPU

生成

华为

工具

AGI

计算

AI设计

生成式AI

大型语言模型

搜索

视频生成

AI模型

亚马逊

特斯拉

DeepMind

场景

深度学习

Copilot

Transformer

架构

MCP

编程

视觉