大块头不等于大智慧。

这在生成式AI领域,已逐渐成为共识。

Gemma 3系列的成功就是一个很好的例证。

在过去几个月,是Gemma 3系列开源模型的高光时刻。

先是Gemma 3和Gemma 3 QAT,在云端和本地桌面加速器上,均跑出了SOTA级别的表现。

紧接着,主打「移动优先」的Gemma 3n完整版,将强大、实时的多模态生成式AI直接带入边缘设备。

上周,Gemma系列模型的总下载量突破了2亿大关,Gemmaverse社区的热度空前高涨。

Google又乘势推出了Gemma 3 270M。

,时长07:22

看名字中的「M」就知道,它的目标不是「通吃一切」,而是要以更低成本、更高效率、更快速度地完成你交给它的活。

小身板,真能打

Gemma 3 270M是Gemma 3系列中参数规模最小的。

别看它个头小,能量却不可小觑。

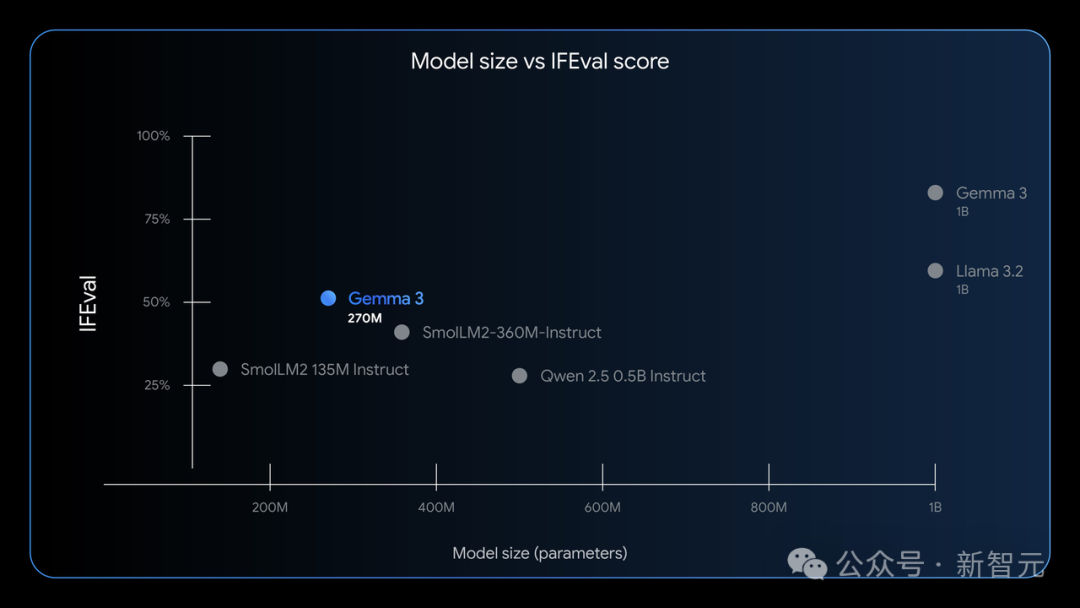

在IFEval基准测试上,Gemma 3 270M树立了性能新标杆。

它的IFEval分数接近50%,显著高于一些相同尺寸甚至更大尺寸的模型。

在小模型阵营里,它是唯一接近50%水平的,意味着它在指令跟随任务中表现非常突出。

再加上其出色的文本结构化能力,让它更适用于面向特定任务的微调,从而在端侧部署和科研应用方面均展现出独特优势。

在效率上,Gemma 3 270M在中小模型中表现最优,甚至超越了更大规模的Qwen 2.5 0.5B和SmolLM2-360M;但与1B级别的模型相比,仍有20~25个百分点的IFEval差距:这是极致压缩带来的不可避免损失。

综合来看,Gemma 3 270M重要的性能亮点有:

小体积,强架构:模型中的1.7亿参数用在词嵌入层,支持256k超大词表,能识别冷门Token,适合细分行业和语言环境下微调使用。剩下1亿参数,则用于Transformer块;

省电狂魔:Google在Pixel 9 Pro上实测,INT4量化版本进行25轮对话只耗0.75%电量,是迄今最节能的Gemma模型;

跟指令超听话:除了预训练版本外,Google还放出了指令微调模型,开箱即用,能直接处理常规的指令类任务;

量产级QAT支持,部署无忧:模型提供了量化感知训练(QAT)版本,可在INT4精度下运行,性能几乎无损,特别适合资源受限设备的部署需求。

用对AI,才能事半功倍

「挂一幅画,你会用铁锤吗?」

这句话提醒我们:用对AI才能事半功倍。

不是每个AI项目,都需要动用几十亿参数的大模型(大锤),更多情况下,像Gemma 3 270M这样的小模型,反而是你需要的那把「AI扳手」。

Gemma 3 270M推出,正是延续了该系列模型「用对工具」的理念。

它是一款「开箱即战」的高性能基础模型,正如上文在它的性能亮点中提到的,出色的指令跟随能力,经过简单微调后,便可以在文本分类、数据抽取等任务中游刃有余。

此外,它还能直接部署在手机,或者树莓派这样的单片机电脑上。

有了这样一个小而强、易部署的模型作为起点,开发者可以打造轻量、快速且极具成本优势的生产系统。

Plaito AI的CTO Greg Mars对Gemma 3 270M颇为赞赏,认为它可以在自己的M4 Pro上极其快速、高质量的运行。

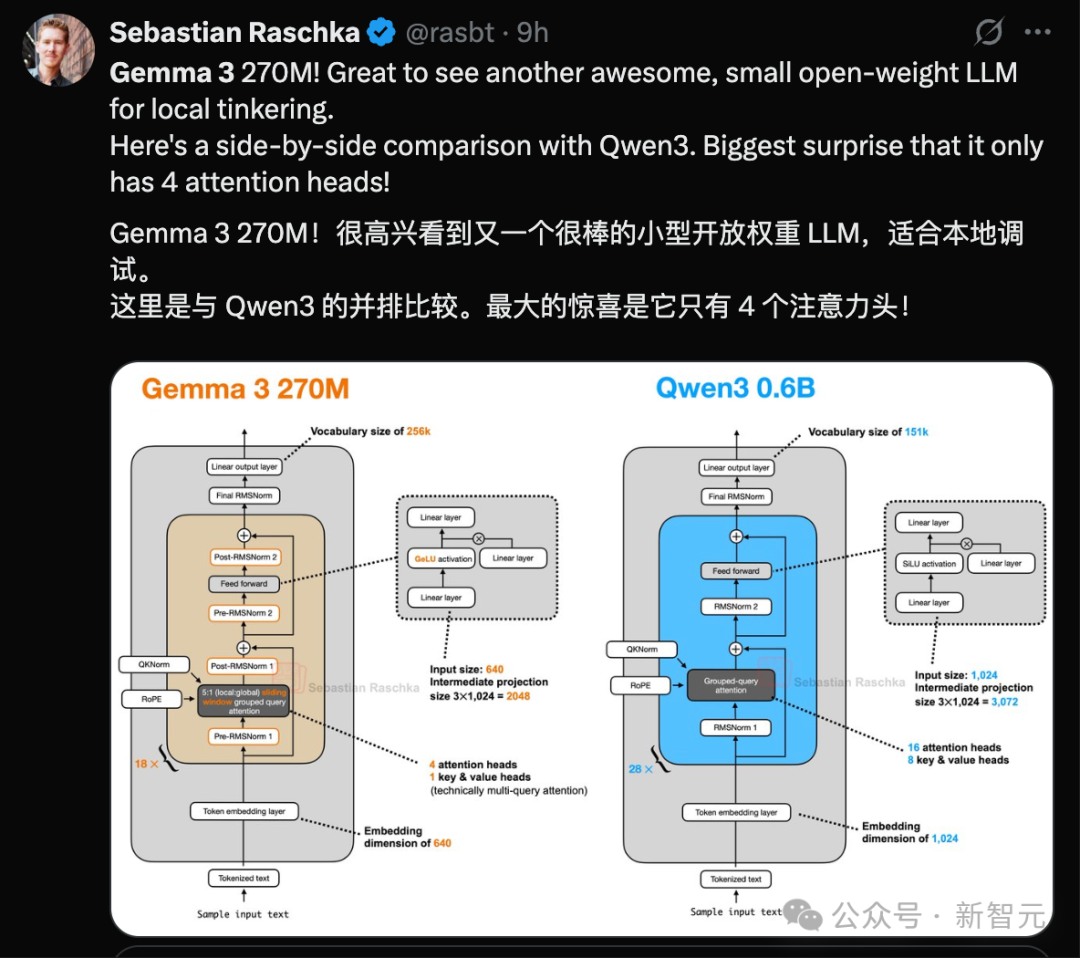

LLM研究工程师Sebastian Raschka,还贴出了Gemma 3 270M和Qwen3 0.6B的并排比较。

他认为最大的惊喜是Gemma 3 270M只有4个注意力头。

和Qwen3 0.6B的16个注意力头相比,Gemma 3 270M只有4个注意力头,这意味着后者在推理时key/value复用率高,显著降低显存占用和延迟。

因此,Gemma 3 270M更适合部署在低配的本地环境。

虽然Gemma 3 270M刚刚发布,但Gemma 3系列在不同规模的任务中,早已展现出「小而专」的威力。

例如,Adaptive ML与SK Telecom合作解决复杂多语言内容审核的难题时,并没有依赖庞大的通用模型,而是选择了微调一个Gemma 3 4B模型。结果不仅达标,甚至超越了更大体量的专有模型。

Gemma 3 270M延续了这一理念,将「小而专」进一步压缩到极致,把高效、精准的特性下放到更多开发者可直接使用的规模。

比如,你可以用它构建一个「多模型小分队」,每个模型专攻一类任务。

但别以为这种小模型只能用在「单调的」企业系统里,它的专业化能力,同样也能在创意领域干点有趣的事。

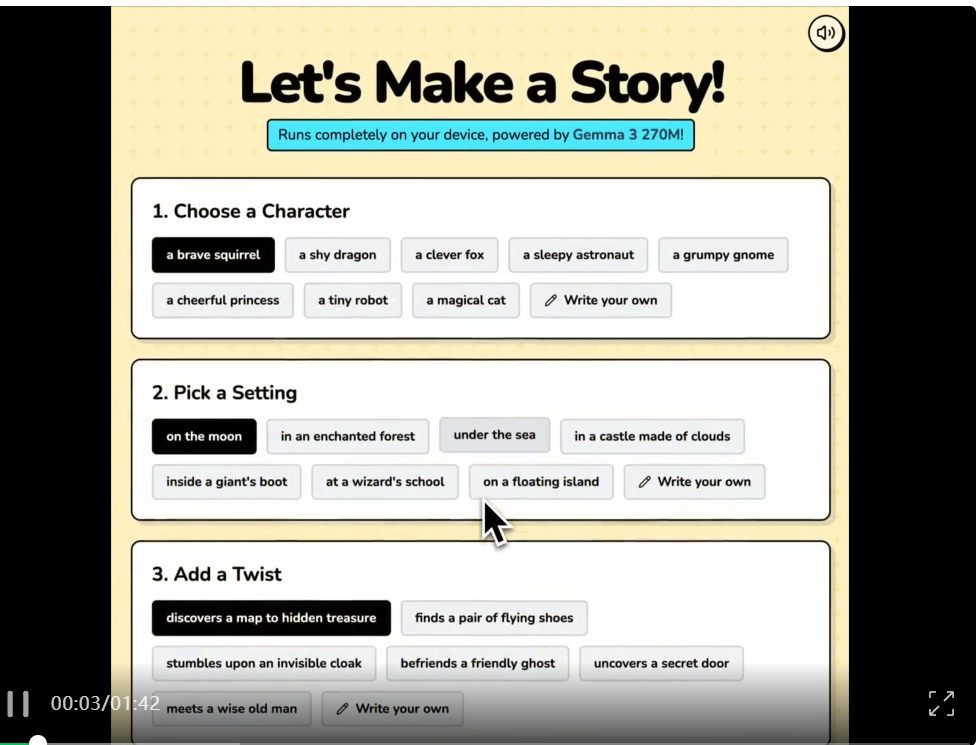

例如,Hugging Face的开发者Joshua,就用Gemma 3 270M搞了个基于Transformers.js的网页应用,生成睡前故事,支持离线运行,还能个性化生成角色和情节。

270M,是谁的「理想型」

Gemma 3 270M承袭了Gemma系列的先进架构与强大预训练,具备打造定制应用的理想基础。

如果你的应用场景与下列条件类似,那它就是你的「理想型」:

任务明确、数据量大的场景:如情感分析、实体识别、查询路由、结构化转换、创意写作和合规检查类任务;

预算有限,对响应速度有高要求:模型微调后,可运行在轻量、低成本的本地或终端设备上,能帮你省下大模型的推理成本,速度更快;

希望快速迭代和上线:它可以小时级别完成微调实验,远快于大模型的开发周期;

需要本地部署,保证隐私:Gemma 3 270M支持完全本地化运行,用户数据无需上传云端;

构建多个小模型一起跑:一台设备上部署多个任务专家模型也不吃力,控制预算的同时实现模型能力最大化。

Gemma 3 270M采用与其他Gemma 3模型一致的架构,并配套提供微调方法与工具,帮助开发者轻松将其打造成自己专属的解决方案。

下载模型:Hugging Face、Ollama、Kaggle、LM Studio、Docker全平台覆盖,可以获取预训练模型及指令微调版本;

试跑体验:在Vertex AI或llama.cpp、Gemma.cpp、LiteRT、Keras、MLX等主流工具上都能玩;

开始微调:使用Hugging Face、UnSloth、JAX等你熟悉的工具开展微调;

部署上线:微调完成后,可部署到本地环境、Google Cloud Run,或任意你选择的平台。

Gemmaverse的核心理念是:创新无关大小。

Gemma 3,尤其是Gemma 3 270M,是开发者构建「专精小模型舰队」的理想起点。虽然它们身板小,却能承担起各种AI实战任务,组团干大活一点也不含糊。

Gemma 3:开发者手中的「瑞士军刀」

2024年2月,Google推出了Gemma系列的首个版本。

作为Gemini的轻量级版本,Google推出它的初衷很简单,让开发者不再为「模型太大跑不动、模型太小能力不够」而纠结。

Gemma 3上线后,「开源友好」「性价比高」「可塑性强」是众多开发者对它的一致评价,俨然已成为开发者AI工具箱里的「瑞士军刀」。

大模型越来越大,随之而来的是越来越严重的「算力焦虑」,市场对于低硬件需求且效能强劲的AI解决方案始终存在着巨大需求。

「模型不求大,够用才是王道」。

Gemma系列的这一设计理念,正是对上述市场趋势的积极回应,这次Gemma 3 270M的发布,更是将该理念推向一个新的阶段。