在当前由大型语言模型(LLM)驱动的应用开发浪潮中,如何赋予模型超越文本生成、具备可靠推理与行动的能力,已成为衡量其智能水平的关键分野。正是在这一背景下,Langchain 框架中的 ReAct(Reasoning and Acting)机制应运而生,并迅速成为业界瞩目的焦点。

ReAct 不仅仅是一种技术实现,更是一种富有远见的智能代理(Agent)设计哲学。

1. 为什么需要 Agent 架构?

众所周知,要理解为何需要 Agent 架构,首先必须认识到大型语言模型(LLM)本身的核心能力与局限。

从本质上讲,LLM 是一个基于概率的文本生成引擎,在其庞大的训练数据范围内,可以出色地完成理解、总结、翻译和创作等任务。然而,其局限性也同样显著,具体体现在如下几个核心方面:

(1) 知识边界的禁锢

LLM 的知识被冻结在最后一次训练的时间点。它无法访问实时信息、内部数据库或专有 API。

(2) 缺乏行动能力

LLM 只能生成文本,却无法执行操作,如发送电子邮件、调用 API、执行代码或查询数据库。因此,我们可以认为它是一个“思考者”,而非“行动者”。

(3) 无状态性

大多数 LLM 的 API 调用是无状态的,不擅长存储或保留之前的交互,除非将整个对话历史作为上下文传入,但这在长流程、复杂任务中会变得低效且有上下文长度限制。

(4) 推理的脆弱性

对于需要多步骤、依赖中间结果的复杂任务,单纯依靠一次性的 Prompt Engineering(提示工程)生成的“思维链”(Chain of Thought)非常脆弱。一旦中间步骤出错,整个推理链条就会崩溃,缺乏纠错和动态调整的能力。

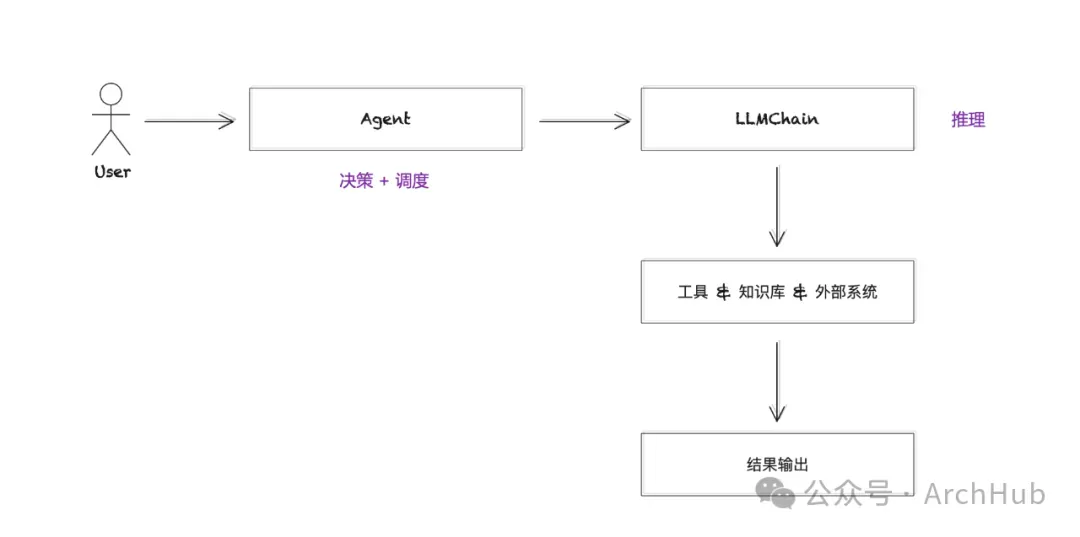

因此,这些局限性意味着,如果仅将 LLM 作为一个独立的组件,只能被动地响应查询,无法主动地、有目的地去解决问题。这正是 Agent 架构出现的根本原因。

作为一种将 LLM 从“引擎” 上升至 “系统”的架构驱动,Agent 架构并非一个具体的算法,而是一种“软件设计模式”和“系统架构思想”。其不仅仅是“让 LLM 使用工具”,而是一种系统化的方法论,旨在:

- 扩展 LLM 的能力边界,使其能够与现实世界进行实时、有意义的交互。

- 增强 LLM 的鲁棒性,通过反馈循环和结构化推理来处理复杂和不确定的任务。

- 提供一个工程化的框架,使得开发者能够以模块化、可扩展和可维护的方式构建复杂的智能系统。

在 LangChain 的语境下,Agent 架构将 LLM 从一个强大的、但被动的语言处理单元(LPU),转变为一个能够自主规划和执行任务的中央处理单元(CPU),是构建下一代 AI Native 应用的核心基石。

2. ReAct (Reason and Act)设计哲学:模仿人类认知方式

其实,从本质上而言,ReAct 的设计哲学深刻地模仿了人类解决问题的过程:我们并非在头脑中构思好每一个完美无缺的步骤后才开始行动,而是在一个“思考 -> 行动 -> 观察 -> 修正思考”的迭代循环中不断前进,具体体现如下:

(1) Reason - 推理

这是对当前任务状态的内部审视和规划。例如:“我需要知道今天香港的天气。我应该使用一个天气查询工具。” 这一步对应了 LLM 生成的 “Thought”。

(2) Act - 行动

这是基于推理结果,与外部世界进行交互的具体步骤。例如:调用天气 API search_weather(city="Singapore")。这一步对应了 LLM 生成的 “Action”。

(3) Observation - 观测

这是行动之后从外部世界获得的反馈。例如:API 返回结果 {"temperature": "31°C", "condition": "Cloudy"}。这是系统提供给模型的 “Observation”。

上述 “Thought -> Action -> Observation”的循环构成了 ReAct 架构的最小原子操作,也是其区别于其他模式的根本特征。它将一个宏大的、复杂的任务,解构成了一系列微观的、可管理、可验证的认知-行动循环。

从软件架构的角度看,ReAct 并非一个单一的类或函数,而是一个由多个松耦合组件构成的协作系统。具体涉及如下:

(1) 编排器 (Orchestrator - AgentExecutor)

作为整个 ReAct 循环的主控引擎和状态机,编排器负责驱动数据在各个组件之间流动,管理循环的生命周期(开始、继续、终止),并执行路由逻辑(是调用工具还是输出最终答案)。这是 ReAct 架构的“心跳”,也是“灵魂”所在。

(2) 决策引擎 (Decision Engine - LLM)

作为系统的认知核心。决策引擎不负责执行,只负责决策。在 ReAct 架构中,决策引擎的任务被严格限定为:接收当前状态的完整上下文,并依据“认知框架”的指示,生成下一步的 Thought 和 Action。

(3) 认知框架 (Cognitive Framework - Prompt Template)

作为 ReAct 架构的核心“固件”或“BIOS”,这是一个精心设计的、高度结构化的提示模板,其作用是约束 LLM 的行为,强制其输出符合 Thought/Action 格式的文本,从而以确保 LLM 能够稳定地在 ReAct 循环中工作的最关键组件。

相对于其他组件而言,认知框架则定义了 LLM 的“世界观”和“行事准则”,对于事件的维护及管理极为重要。

(4) 执行层 (Execution Layer - Tools)

作为系统的感知和行动单元,每个工具都是一个标准化的、封装良好的函数或类,代表一项原子能力(如 API调用、数据库查询)。工具的描述(description)至关重要,它构成了工具与决策引擎之间的“API 契约”,LLM 正是根据这个描述来决定使用哪个工具。

执行层的架构意义在于 实现了决策与执行的彻底解耦。我们可以随时增删或替换工具,而无需改动编排器或认知框架,这使得系统具有极强的可扩展性。

(5) 输出解析器 (Output Parser)

作为协议转换器,输出解析器负责将 LLM 生成的、非结构化的自然语言文本,转换为编排器可以理解和执行的、结构化的数据对象(如 AgentAction 或 AgentFinish)。它弥合了 LLM 的“软”输出与系统“硬”逻辑之间的鸿沟。

(6) 状态暂存器 (State Scratchpad)

作为 ReAct 循环的短期记忆,状态暂存器在每一次循环中动态构建,记录了从开始到当前步骤的所有 (Action, Observation) 对。这个“暂存器”会被注入到认知框架中,为 LLM 提供决策所需的全部历史上下文,让它知道“我从哪里来”以及“我刚刚做了什么,结果如何”。

部分代码示例,可参考如下:

复制3. 如何看待 ReAct 架构的优劣势 ?

其实,基于上述的架构解析,我们可以看到:ReAct 不仅仅是一种“让 LLM 用工具”的技术,更是一种深刻的架构范式。它将 LLM 的角色从一个被动的、全知的“知识库”转变为一个主动的、探索性的“推理代理”(Reasoning Agent)。

在架构层面,ReAct 的核心贡献是定义了一套标准的组件、协议和控制流,用于构建一个能够将 LLM 的认知能力与外部世界的真实性相结合的反馈控制系统。以牺牲部分性能为代价,换取了前所未有的鲁棒性、灵活性和任务解决能力的泛化,为构建更强大、更可靠的 AI 应用奠定了坚实的架构基础。

这种设计赋予了基于 LLM 的应用前所未有的可靠性与透明度。通过显式化的推理步骤,开发者和用户可以清晰地洞察模型的决策逻辑,极大地提升了系统的可解释性和可信度。更重要的是,通过与外部工具的协同,ReAct 机制有效突破了大型语言模型固有的知识局限性和“幻觉”问题,使其能够获取并处理实时、动态的信息,从而在复杂、多跳的真实世界任务中展现出卓越的性能。

因此,深入理解并应用 Langchain ReAct 机制,对于任何希望构建真正智能、可靠且功能强大的语言模型应用的开发者而言,都具有至关重要的战略意义。

Happy Coding ~

Reference :[1] https://www.langchain.com

Adiós !