大模型

实测,Claude Code 配合国内大模型,一样很牛x(完整配置教程)

差别确实是有的,因为 AI Agent 的能力取决于大模型 和 Agent 终端工程化两方面的能力,这两个工具之所以厉害,除了模型外,优秀的 Agent 终端工程能力也占了一半功劳。 所以,换了其他终端后,如果终端能力不行,依然没办法发挥优势。 还有个问题,那就是 Droid 依然是国外的产品。

10/16/2025 3:22:00 AM

风筝

Traefik vs Agent Middleware,谈 Middleware 如何成为现代分布式架构的“控制中枢”?

Hello folks,我是 Luga,今天我们来聊一下人工智能应用场景 - 构建大模型应用架构技术框架:Middleware。 在现代分布式系统的世界里,真正决定系统稳定性与智能化程度的,并非那些看得见的核心模块,而往往是藏在背后的“中间层”——Middleware(中间件)。 作为一位无声的指挥者,其掌控着数据流转的节奏、请求调度的路径,以及智能决策的触发逻辑。

10/15/2025 9:39:31 AM

Luga Lee

国内安全厂商应对大模型新风险的主要措施

大型语言模型(LLMs)的飞速发展,正在为企业带来前所未有的业务创新,但同时也带来了一系列超出传统网络安全范畴的“新”威胁。 攻击者不再满足于入侵服务器,而是通过恶意输入来操纵模型行为、窃取模型数据甚至损害模型本身,这些新威胁使得为大模型构建一个强大的安全防护体系,成为企业在AI时代下的当务之急。 那么,国内厂商是如何应对这些“新”威胁,我们又该如何防御呢?

10/15/2025 12:00:00 AM

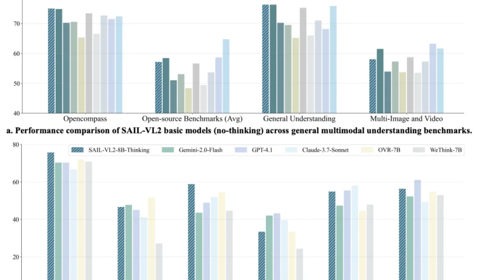

抖音&LV-NUS开源多模态新模,以小博大刷新SOTA,8B推理比肩GPT-4o

SAIL-VL2团队 投稿. 量子位 | 公众号 QbitAI2B模型在多个基准位列4B参数以下开源第一。 抖音SAIL团队与LV-NUS Lab联合推出的多模态大模型SAIL-VL2。

10/14/2025 11:17:20 AM

西风

LLM-as-a-Judge 的评估陷阱:TrustJudge 如何用熵保留机制提升一致性

大家好,我是肆〇柒。 今天要和大家一起阅读一项来自北京大学、新加坡国立大学、东京科学研究所、南京大学、Google DeepMind、西湖大学与东南大学等机构联合发表的重要研究——《TrustJudge: Inconsistencies of LLM-as-a-Judge and How to Alleviate Them》。 这项工作首次系统揭示了当前主流大模型自动评估范式中存在的两类根本性逻辑矛盾,并提出了一套无需额外训练、即插即用的概率化评估框架,显著提升了评估的一致性与可靠性。

10/14/2025 9:22:48 AM

肆零柒

剑桥揭开大模型翻车黑箱!别再怪它不懂推理,是行动出错了

大模型也有「EMO」时刻。 比如,Gemini在Cursor里调试编译错误后,打开了自责「循环模式」,把「I am a disgrace(我很丢脸)」重复了86次。 尽管大模型在复杂推理能力上已有了巨大进步,但上述现象仍使一部分专家认为:思考模型,只提供了「思考的幻觉」,因为当任务被拉长时它们最终会失败。

10/14/2025 9:04:00 AM

大模型赋能文化遗产数字化:古籍修复与知识挖掘的技术实践

在文化遗产数字化领域,大模型的核心应用难点在于如何处理古籍中大量的异体字、残缺文本与模糊语义,尤其是面对明清时期的手写残卷,传统的文字识别技术不仅准确率低下,更无法理解古籍中蕴含的历史语境与专业术语。 我在参与某博物馆古籍数字化项目时,首先遭遇的便是大模型对古籍文字的“识别盲区”—初期使用通用大模型识别一本明代医学残卷,发现其将“癥瘕”误判为“症痕”,把“炮制”错解为“泡制”,更无法关联“君臣佐使”等中医方剂配伍逻辑,导致提取的知识完全偏离原意。 为解决这一困境,我没有直接进行模型微调,而是先搭建“古籍文字与语境知识库”:通过整理《说文解字》《康熙字典》等权威字书,以及近现代古籍整理学术成果,构建包含5000 异体字、通假字的对照词典,每个文字标注字形演变、常见语境与释义差异;同时,针对医学、天文、历法等专业领域古籍,收集对应的行业术语库,标注术语的历史用法与现代对应概念(如“勾陈”对应天文领域的“小熊座”)。

10/13/2025 6:10:28 PM

许辉

GPT-6或要有生命了!MIT神作:一套神框架让大模型“自己微调自己”,实验已通过!超过GPT4.1,网友:冻结权重时代结束了

编辑 | 云昭出品 | 51CTO技术栈(微信号:blog51cto)在过去两年,大语言模型几乎定义了整个 AI 发展的节奏。 但有个问题一直没变:模型再强,也不会自己学习。 每次要让它掌握新知识,都必须人工投喂数据、重新训练。

10/13/2025 2:00:24 PM

云昭

超越ZIP的无损压缩来了!华盛顿大学让大模型成为无损文本压缩器

当大语言模型生成海量数据时,数据存储的难题也随之而来。 对此,华盛顿大学(UW)SyFI实验室的研究者们提出了一个创新的解决方案:LLMc,即利用大型语言模型自身进行无损文本压缩的引擎。 基准测试结果表明,无论是在维基百科、小说文本还是科学摘要等多种数据集上,LLMc的压缩率都优于传统的压缩工具(如ZIP和LZMA)。

10/11/2025 6:05:23 PM

Anthropic 最新研究:仅需250份恶意文档,大模型即可被攻陷,无关参数规模

2025年10月8日,英国AI安全研究院、Anthropic、艾伦·图灵研究所与牛津大学OATML实验室等机构联合发布的一项研究,打破了业界关于“大模型越大越安全”的核心假设。 这项研究题为《Poisoning Attacks on LLMs Require a Near-constant Number of Poison Samples》,论文发表于arXiv。 研究团队发现,只需约250个恶意文档,就足以在任意规模的大语言模型(LLM)中植入可触发的后门(Backdoor)。

10/11/2025 3:18:35 PM

蚂蚁新发万亿开源旗舰大模型,究竟有多强?

国产大模型最近真是百花齐放啊,卷到家了。 这不,蚂蚁最近也发布了他的万亿级开源大模型 Ling 1T,把大模型的数量级又拉升到了新的高度。 那这个大模型到底好不好用呢?

10/11/2025 10:04:00 AM

磊哥

别再给大模型打鸡血,先救救被“智能体”三个字忽悠的预算

“兄弟,我们老板昨天看完路演,拍桌子要上Agent,说三个月让客服成本归零。 ”“归零? 他以为Agent是灭霸,打个响指预算就蒸发?

10/11/2025 9:40:11 AM

大数据AI智能圈

RLPT:用强化学习“重读”预训练数据,让大模型学会思考

大家好,我是肆〇柒。 今天要和大家分享的是一项来自腾讯大模型部门(LLM Department, Tencent) 与香港中文大学合作的前沿研究——RLPT(Reinforcement Learning on Pre-Training Data)。 面对高质量数据增长见顶、计算资源持续膨胀的矛盾,这项工作提出了一种全新的训练范式:让大模型在原始预训练数据上通过强化学习自主探索推理路径,从而突破传统监督学习的泛化瓶颈。

10/11/2025 9:23:28 AM

肆零柒

无标签进化:EVOL-RL用“多数选择+新颖变异”破解大模型“熵坍缩”困局

大家好,我是肆〇柒。 今天要和大家探讨的,是来自腾讯AI Lab、圣母大学及弗吉尼亚大学核心研究团队的一项突破性工作——《Evolving Language Models without Labels: Majority Drives Selection, Novelty Promotes Variation》。 这项研究直指当前无监督学习的核心痛点:为何主流方法会让AI越学越“笨”?

9/28/2025 9:17:40 AM

肆零柒

让大模型合成检查器:UIUC团队挖出Linux内核90余个长期潜伏漏洞

这篇论文的作者来自伊利诺伊大学香槟分校(UIUC)张令明老师团队,包括:杨晨源,四年级博士生,研究方向是基于 AI 大模型的软件系统可靠性保障;赵子杰,四年级博士生,研究方向是模糊测试等软件工程技术与 AI 大模型的结合;谢子晨,科研实习生,目前为弗吉尼亚大学一年级博士生;李皓宇,科研实习生,目前为 UIUC 一年级博士生。 张令明老师现任 UIUC 计算机系副教授,主要从事软件工程、机器学习、代码大模型的相关研究。 想象一下,大语言模型不仅能生成代码,还能通过静态分析看代码找漏洞:在千万行的 Linux 内核代码中挖出 92 个长期潜伏的真实缺陷 —— 这也可能是 LLM 首次在 Linux 内核中发现如此多的实际漏洞。

9/28/2025 9:13:00 AM

估值840亿AI实验室再放大招,他们要给大模型戴上「紧箍咒」

刚刚,OpenAI前CTO Mira Murati创办的Thinking Machines Lab再次发布成果! 这是他们继《克服LLM推理中的不确定性》(Defeating Nondeterminism in LLM Inference)之后,第二篇研究文章——《模块流形》(Modular Manifolds)。 博客地址:「走钢丝」,必须小心翼翼地维持其内部「健康」,防止权重、激活值或梯度这些关键张量变得过大或过小,以免引发数值溢出等一系列问题。

9/28/2025 9:11:00 AM

从探索到验证:Parallel-R1 如何塑造大模型的"思考"哲学

大家好,我是肆〇柒。 今天看看由腾讯AI Lab Seattle联合马里兰大学、北卡罗来纳大学、香港城市大学和圣路易斯华盛顿大学共同研究的工作——Parallel-R1,它首次通过强化学习让大语言模型真正掌握了"并行思考"这一人类高级认知能力,而非仅依赖推理时策略的临时拼凑。 这项研究不仅刷新了AIME25数学竞赛基准测试的准确率记录,更揭示了机器"思考"方式的演化规律。

9/28/2025 9:00:00 AM

肆零柒

GGUF 是什么?一文看懂大模型里最火的模型格式

图片最近你要是混迹在 AI 圈,或者经常玩 Hugging Face、CSDN、GitHub 上的开源模型,肯定会碰到一个后缀:👉 .gguf比如:qwen2-7b-instruct.Q4_K_M.gguf很多人第一次见到就一头雾水:这是模型吗? 压缩包吗? 还是量化格式?

9/28/2025 1:55:00 AM

道玄

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

Midjourney

开源

Meta

AI新词

微软

智能

用户

GPT

学习

技术

智能体

马斯克

Gemini

图像

Anthropic

英伟达

AI创作

训练

LLM

论文

代码

算法

Agent

AI for Science

芯片

苹果

Claude

腾讯

Stable Diffusion

蛋白质

开发者

生成式

神经网络

xAI

机器学习

3D

RAG

人形机器人

AI视频

研究

大语言模型

生成

具身智能

Sora

工具

GPU

百度

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

视频生成

场景

深度学习

架构

生成式AI

DeepMind

编程

视觉

Transformer

预测

亚马逊

AI模型

特斯拉

MCP